TRAVAIL DE COURS

Sujet : Analyse de corrélation

Introduction

1. Analyse de corrélation

1.1 La notion de corrélation

1.2 Classification générale des corrélations

1.3 Champs de corrélation et but de leur construction

1.4 Étapes de l'analyse de corrélation

1.5 Coefficients de corrélation

1.6 Coefficient de corrélation Bravais-Pearson normalisé

1.7 Coefficient de corrélation de rang de Spearman

1.8 Propriétés de base des coefficients de corrélation

1.9 Vérification de la significativité des coefficients de corrélation

1.10 Valeurs critiques du coefficient de corrélation de paire

2. Planifier une expérience multifactorielle

2.1 État du problème

2.2 Détermination du centre du plan (niveau de base) et du niveau de variation des facteurs

2.3 Construction de la matrice de planification

2.4 Vérification de l'homogénéité de la dispersion et de l'équivalence des mesures dans différentes séries

2.5 Coefficients de l'équation de régression

2.6 Variation de reproductibilité

2.7 Vérification de la signification des coefficients de l'équation de régression

2.8 Vérification de l'adéquation de l'équation de régression

Conclusion

Bibliographie

INTRODUCTION

La planification expérimentale est une discipline mathématique et statistique qui étudie les méthodes d'organisation rationnelle de la recherche expérimentale - du choix optimal des facteurs étudiés et de la détermination du plan expérimental réel conformément à son objectif jusqu'aux méthodes d'analyse des résultats. La planification expérimentale a commencé avec les travaux du statisticien anglais R. Fisher (1935), qui a souligné que la planification expérimentale rationnelle n'apporte pas de gains moins significatifs en termes de précision des estimations que le traitement optimal des résultats de mesure. Dans les années 60 du 20e siècle, la théorie moderne de la planification expérimentale a émergé. Ses méthodes sont étroitement liées à la théorie de l'approximation des fonctions et à la programmation mathématique. Des plans optimaux ont été construits et leurs propriétés ont été étudiées pour une large classe de modèles.

La planification expérimentale est la sélection d'un plan expérimental répondant à des exigences spécifiées, un ensemble d'actions visant à développer une stratégie d'expérimentation (de l'obtention d'informations a priori à l'obtention d'un modèle mathématique réalisable ou à la détermination des conditions optimales). Il s'agit d'un contrôle délibéré d'une expérience, mise en œuvre dans des conditions de connaissance incomplète du mécanisme du phénomène étudié.

Au cours du processus de mesure, du traitement ultérieur des données, ainsi que de la formalisation des résultats sous la forme d'un modèle mathématique, des erreurs surviennent et certaines des informations contenues dans les données d'origine sont perdues. L'utilisation de méthodes de planification expérimentale permet de déterminer l'erreur du modèle mathématique et de juger de son adéquation. Si la précision du modèle s'avère insuffisante, alors l'utilisation de méthodes de planification expérimentale permet de moderniser le modèle mathématique avec des expériences supplémentaires sans perdre les informations antérieures et avec des coûts minimes.

Le but de la planification d'une expérience est de trouver des conditions et des règles pour mener des expériences dans lesquelles il est possible d'obtenir des informations fiables et fiables sur un objet avec le moins de travail possible, ainsi que de présenter ces informations sous une forme compacte et pratique. avec une évaluation quantitative de l’exactitude.

Parmi les principales méthodes de planification utilisées aux différentes étapes de l’étude figurent :

Planifier une expérience de dépistage, dont la signification principale est la sélection parmi l'ensemble des facteurs d'un groupe de facteurs significatifs qui font l'objet d'une étude plus détaillée ;

Plan expérimental pour l'ANOVA, c'est-à-dire élaborer des plans d'objets avec des facteurs qualitatifs ;

Planifier une expérience de régression qui permet d'obtenir des modèles de régression (polynomiale et autres) ;

Planifier une expérience extrême dans laquelle la tâche principale est l'optimisation expérimentale de l'objet de recherche ;

Planification lors de l'étude de processus dynamiques, etc.

Le but de l'étude de la discipline est de préparer les étudiants aux activités de production et techniques de leur spécialité en utilisant les méthodes de la théorie de la planification et des technologies de l'information modernes.

Objectifs de la discipline : étude des méthodes modernes de planification, d'organisation et d'optimisation des expérimentations scientifiques et industrielles, de conduite des expérimentations et de traitement des résultats obtenus.

1. ANALYSE DE CORRÉLATION

1.1 Le concept de corrélation

Un chercheur s’intéresse souvent à la manière dont deux ou plusieurs variables sont liées les unes aux autres dans un ou plusieurs échantillons étudiés. Par exemple, la taille peut-elle affecter le poids d'une personne, ou la tension artérielle peut-elle affecter la qualité du produit ?

Ce type de dépendance entre variables est appelé corrélation ou corrélation. Une corrélation est un changement constant de deux caractéristiques, reflétant le fait que la variabilité d’une caractéristique est conforme à la variabilité de l’autre.

On sait, par exemple, qu’il existe en moyenne une relation positive entre la taille des personnes et leur poids, et que plus la taille est grande, plus le poids de la personne est élevé. Cependant, il existe des exceptions à cette règle, lorsque les personnes relativement petites sont en surpoids et, à l'inverse, les personnes asthéniques de grande taille ont un faible poids. La raison de ces exceptions est que chaque signe biologique, physiologique ou psychologique est déterminé par l'influence de nombreux facteurs : environnementaux, génétiques, sociaux, environnementaux, etc.

Les connexions de corrélation sont des changements probabilistes qui ne peuvent être étudiés que sur des échantillons représentatifs en utilisant les méthodes des statistiques mathématiques. Les deux termes – lien de corrélation et dépendance de corrélation – sont souvent utilisés de manière interchangeable. La dépendance implique l'influence, la connexion - tout changement coordonné qui peut s'expliquer par des centaines de raisons. Les liens de corrélation ne peuvent pas être considérés comme la preuve d'une relation de cause à effet ; ils indiquent seulement que les changements dans une caractéristique s'accompagnent généralement de certains changements dans une autre.

Dépendance à la corrélation - Ce sont des changements qui introduisent les valeurs d'une caractéristique dans la probabilité d'apparition de différentes valeurs d'une autre caractéristique.

La tâche de l'analyse de corrélation revient à établir la direction (positive ou négative) et la forme (linéaire, non linéaire) de la relation entre différentes caractéristiques, à mesurer sa proximité et, enfin, à vérifier le niveau de signification des coefficients de corrélation obtenus.

Les connexions de corrélation varient en forme, direction et degré (force) .

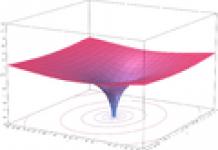

La forme de la relation de corrélation peut être linéaire ou curviligne. Par exemple, la relation entre le nombre de séances de formation sur simulateur et le nombre de problèmes correctement résolus lors de la séance de contrôle peut être simple. Par exemple, la relation entre le niveau de motivation et l’efficacité d’une tâche peut être curviligne (Figure 1). À mesure que la motivation augmente, l'efficacité de l'accomplissement d'une tâche augmente d'abord, puis le niveau optimal de motivation est atteint, ce qui correspond à l'efficacité maximale de l'accomplissement de la tâche ; Une nouvelle augmentation de la motivation s’accompagne d’une diminution de l’efficacité.

Figure 1 - Relation entre l'efficacité de la résolution de problèmes et la force des tendances motivationnelles

En direction, la relation de corrélation peut être positive (« directe ») et négative (« inverse »). Avec une corrélation linéaire positive, les valeurs plus élevées d'une caractéristique correspondent aux valeurs plus élevées d'une autre, et les valeurs plus faibles d'une caractéristique correspondent aux valeurs faibles d'une autre (Figure 2). Avec une corrélation négative, les relations sont inverses (Figure 3). Avec une corrélation positive, le coefficient de corrélation a un signe positif, avec une corrélation négative, il a un signe négatif.

Figure 2 – Corrélation directe

Figure 3 – Corrélation inverse

Figure 4 – Aucune corrélation

Le degré, la force ou l'étroitesse de la corrélation est déterminé par la valeur du coefficient de corrélation. La force de la connexion ne dépend pas de sa direction et est déterminée par la valeur absolue du coefficient de corrélation.

1.2 Classification générale des corrélations

Selon le coefficient de corrélation, on distingue les corrélations suivantes :

Fort ou proche avec un coefficient de corrélation r>0,70 ;

Moyenne (à 0,50 Modéré (à 0,30 Faible (à 0,20 Très faible (à r<0,19). 1.3 Champs de corrélation et but de leur construction La corrélation est étudiée sur la base de données expérimentales, qui sont les valeurs mesurées (x i, y i) de deux caractéristiques. S'il existe peu de données expérimentales, alors la distribution empirique bidimensionnelle est représentée comme une double série de valeurs x i et y i. Dans le même temps, la dépendance de corrélation entre les caractéristiques peut être décrite de différentes manières. La correspondance entre un argument et une fonction peut être donnée par un tableau, une formule, un graphique, etc. L'analyse de corrélation, comme d'autres méthodes statistiques, repose sur l'utilisation de modèles probabilistes qui décrivent le comportement des caractéristiques étudiées dans une certaine population générale à partir de laquelle les valeurs expérimentales xi et y i sont obtenues. Lors de l'étude de la corrélation entre des caractéristiques quantitatives dont les valeurs peuvent être mesurées avec précision en unités d'échelles métriques (mètres, secondes, kilogrammes, etc.), un modèle de population bidimensionnel normalement distribué est très souvent adopté. Un tel modèle affiche graphiquement la relation entre les variables x i et y i sous la forme d'une localisation géométrique de points dans un système de coordonnées rectangulaires. Cette relation graphique est également appelée nuage de points ou champ de corrélation. Avec connexion de corrélationà la même valeur d'une caractéristique correspond des valeurs différentes d'une autre. Par exemple : il existe une corrélation entre la taille et le poids, entre l'incidence des tumeurs malignes et l'âge, etc. Il existe 2 méthodes pour calculer le coefficient de corrélation : la méthode des carrés (Pearson), la méthode des rangs (Spearman). La plus précise est la méthode des carrés (Pearson), dans laquelle le coefficient de corrélation est déterminé par la formule : , où r xy est le coefficient de corrélation entre les séries statistiques X et Y. d x est l'écart de chacun des nombres de la série statistique X par rapport à sa moyenne arithmétique. d y est l'écart de chacun des nombres de la série statistique Y par rapport à sa moyenne arithmétique. Selon la force de la connexion et sa direction, le coefficient de corrélation peut aller de 0 à 1 (-1). Un coefficient de corrélation de 0 indique une absence totale de connexion. Plus le niveau du coefficient de corrélation est proche de 1 ou (-1), plus le direct ou le feedback qu'il mesure est d'autant plus élevé et plus précis. Lorsque le coefficient de corrélation est égal à 1 ou (-1), la connexion est complète et fonctionnelle. Schéma d'évaluation de la force de corrélation à l'aide du coefficient de corrélation

Le pouvoir de la connexion La valeur du coefficient de corrélation si disponible connexion directe (+) retour (-) Pas de connection La connexion est petite (faible) de 0 à +0,29 de 0 à –0,29 Connexion moyenne (modérée) de +0,3 à +0,69 de –0,3 à –0,69 La connexion est grande (forte) de +0,7 à +0,99 de –0,7 à –0,99 Communication complète (fonctionnel) Pour calculer le coefficient de corrélation par la méthode des carrés, un tableau de 7 colonnes est établi. Examinons le processus de calcul à l'aide d'un exemple : DÉTERMINER LA FORCE ET LA NATURE DE LA CONNEXION ENTRE C'est l'heure- ness goitre (V oui )

d X = V X –M X d y = V oui –M oui d X d oui d X 2

d oui 2

Σ

-1345

,0

Σ

13996

,0

Σ

313

,

47

1. Déterminez la teneur moyenne en iode de l'eau (en mg/l). 2. Déterminez l’incidence moyenne du goitre en %. 3. Déterminez l'écart de chaque V x par rapport à M x, c'est-à-dire dx. 201-138=63 ; 178-138=40, etc. 4. De même, nous déterminons l'écart de chaque V y par rapport à M y, c'est-à-dire d y. 0,2–3,8=-3,6 ; 0,6–38=-3,2, etc. 5. Déterminez les produits des écarts. Nous résumons le produit résultant et obtenons. 6. Nous mettons au carré d x et résumons les résultats, nous obtenons. 7. De même, on met au carré d y, on résume les résultats, on obtient 8. Enfin, nous substituons tous les montants reçus dans la formule : Pour résoudre le problème de la fiabilité du coefficient de corrélation, son erreur moyenne est déterminée à l'aide de la formule : (Si le nombre d’observations est inférieur à 30, alors le dénominateur est n–1). Dans notre exemple La valeur du coefficient de corrélation est considérée comme fiable si elle est au moins 3 fois supérieure à son erreur moyenne. Dans notre exemple Ainsi, le coefficient de corrélation n’est pas fiable, ce qui nécessite une augmentation du nombre d’observations. Le coefficient de corrélation peut être déterminé d'une manière légèrement moins précise, mais beaucoup plus simple : la méthode des rangs (Spearman). Méthode de Spearman : P=1-(6∑d 2 /n-(n 2 -1)) créer deux rangées de caractéristiques comparables appariées, désignant respectivement la première et la deuxième rangée x et y. Dans ce cas, présentez la première ligne de la caractéristique par ordre décroissant ou croissant, et placez les valeurs numériques de la deuxième ligne en face des valeurs de la première ligne auxquelles elles correspondent remplacer la valeur de la caractéristique dans chacune des séries comparées par un numéro d'ordre (rang). Les rangs, ou nombres, indiquent les emplacements des indicateurs (valeurs) des première et deuxième lignes. Dans ce cas, les rangs doivent être attribués aux valeurs numériques du deuxième attribut dans le même ordre que celui adopté lors de leur attribution aux valeurs du premier attribut. Avec des valeurs identiques d'une caractéristique dans une série, les rangs doivent être déterminés comme le nombre moyen à partir de la somme des nombres ordinaux de ces valeurs. déterminer la différence de rang entre x et y (d) : d = x - y mettre au carré la différence de rang résultante (d 2) obtenir la somme des carrés de la différence (Σ d 2) et substituer les valeurs résultantes dans la formule : Exemple:À l'aide de la méthode du classement, établissez la direction et la force de la relation entre les années d'expérience de travail et la fréquence des blessures si les données suivantes sont obtenues : Justification du choix de la méthode : Pour résoudre le problème, seule la méthode de corrélation de rang peut être choisie, car La première rangée de l'attribut « expérience professionnelle en années » comporte des options ouvertes (expérience professionnelle jusqu'à 1 an et 7 ans ou plus), ce qui ne permet pas l'utilisation d'une méthode plus précise - la méthode des carrés - pour établir un lien entre les caractéristiques comparées. Solution. La séquence de calculs est présentée dans le texte, les résultats sont présentés sous forme de tableau. 2. Tableau 2 Expérience professionnelle en années Nombre de blessés Nombres ordinaux (rangs) Différence de classement Différence de rang au carré d(x-y) d 2

Chacune des lignes de caractéristiques appariées est désignée par « x » et « y » (colonnes 1-2). La valeur de chaque caractéristique est remplacée par un nombre de rang (ordinal). L'ordre de répartition des rangs dans la ligne « x » est le suivant : la valeur minimale de l'attribut (expérience jusqu'à 1 an) se voit attribuer le numéro de série « 1 », les variantes suivantes de la même ligne d'attribut, respectivement, dans ordre croissant, 2ème, 3ème, 4ème et 5ème numéros de série - rangs (voir colonne 3). Un ordre similaire est suivi lors de la distribution des classements au deuxième attribut « y » (colonne 4). Dans les cas où il existe plusieurs options d'égale ampleur (par exemple, dans le problème standard, il s'agit de 12 et 12 blessures pour 100 travailleurs avec une expérience de 3-4 ans et 5-6 ans, le numéro de série est désigné par le nombre moyen de la somme de leurs numéros de série. Ces données sur le nombre de blessures (12 blessures) lors du classement devraient occuper 2 et 3 places, donc leur nombre moyen est (2 + 3) / 2 = 2,5. Ainsi, le nombre de blessures « 12 » et « 12 » (attribut ), les mêmes numéros de rang doivent être distribués - « 2,5 » (colonne 4). Déterminer la différence de rang d = (x - y) - (colonne 5) Mettez au carré la différence de rang (d 2) et obtenez la somme des carrés de la différence de rang Σ d 2 (colonne 6). Calculez le coefficient de corrélation de rang à l'aide de la formule : C'est une valeur qui peut varier de +1 à -1. Dans le cas d'une corrélation positive complète, ce coefficient est égal à plus 1 (on dit que lorsque la valeur d'une variable augmente, la valeur d'une autre variable augmente), et dans le cas d'une corrélation complètement négative, il est de moins 1 (indiquant un retour d'information, c'est-à-dire que lorsque les valeurs d'une variable augmentent, les valeurs de l'autre diminuent). Graphique de la relation entre la timidité et la dépression. Comme vous pouvez le constater, les points (sujets) ne sont pas situés de manière chaotique, mais s'alignent autour d'une ligne et, en regardant cette ligne, nous pouvons dire que plus la timidité d'une personne est élevée, plus la dépression est grande, c'est-à-dire que ces phénomènes sont interconnectés. Ex2 : Tableau de timidité et de sociabilité. Nous constatons qu’à mesure que la timidité augmente, la sociabilité diminue. Leur coefficient de corrélation est de 0,43. Ainsi, un coefficient de corrélation supérieur à 0 à 1 indique une relation directement proportionnelle (plus il y a... plus...), et un coefficient de -1 à 0 indique une relation inversement proportionnelle (plus il y a... moins. ..) Si le coefficient de corrélation est égal à 0, les deux variables sont totalement indépendantes l’une de l’autre. Corrélation- il s'agit d'une relation dans laquelle l'impact de facteurs individuels n'apparaît que sous forme de tendance (en moyenne) lors de l'observation massive de données réelles. Des exemples de dépendances de corrélation peuvent être les dépendances entre la taille des actifs de la banque et le montant des bénéfices de la banque, la croissance de la productivité du travail et l’ancienneté des employés. Deux systèmes sont utilisés pour classer les corrélations selon leur force : générale et spécifique. Classification générale des corrélations :

1) fort, ou proche avec un coefficient de corrélation r > 0,70 ; 2) moyenne à 0,50< r < 0,69;

3) modéré à 0,30< r < 0,49;

4) faible à 0,20< r < 0,29;5) очень слабая при r < 0,19.

Classification particulière des corrélations :

1) corrélation significative élevée avec r correspondant au niveau de signification statistique ρ ≤ 0,01 2) corrélation significative avec r correspondant au niveau de signification statistique ρ ≤ 0,05 ; 3) la tendance à une relation significative avec r correspondant au niveau de signification statistique ρ ≤ 0,10 ; 4) corrélation insignifiante avec r n'atteignant pas le niveau de signification statistique. Ces deux classements ne sont pas identiques. Le premier se concentre uniquement sur la valeur du coefficient de corrélation et le second détermine le niveau de signification qu'atteint une valeur donnée du coefficient de corrélation pour une taille d'échantillon donnée. Plus la taille de l’échantillon est grande, plus le coefficient de corrélation est suffisant pour que la corrélation soit considérée comme fiable. Par conséquent, avec un échantillon de petite taille, il se peut qu’une forte corrélation ne soit pas significative. Dans le même temps, avec des échantillons de grande taille, même une faible corrélation peut s’avérer fiable. Il est généralement habituel de se concentrer sur la deuxième classification, car elle prend en compte la taille de l’échantillon. Cependant, il faut garder à l’esprit qu’une corrélation forte ou élevée est une corrélation avec un r > 0,70, et pas seulement une corrélation d’un niveau de signification élevé. Le tableau suivant montre les noms des coefficients de corrélation pour différents types d'échelles. À r= 0

Il n'y a pas de corrélation linéaire. Dans ce cas, les moyennes de groupe des variables coïncident avec leurs moyennes générales et les droites de régression sont parallèles aux axes de coordonnées. Égalité r= 0

ne parle que de l'absence de dépendance de corrélation linéaire (non-corrélation des variables), mais pas généralement de l'absence de corrélation, et plus encore de dépendance statistique. Parfois, la constatation d’une absence de corrélation est plus importante que la présence d’une forte corrélation. Une corrélation nulle entre deux variables peut indiquer qu’il n’y a aucune influence d’une variable sur l’autre, à condition de faire confiance aux résultats de mesure. Dans SPSS : 11.3.2 Coefficients de corrélation Jusqu'à présent, nous avons seulement clarifié le fait de l'existence d'une relation statistique entre deux caractéristiques. Nous tenterons ensuite de savoir quelles conclusions peuvent être tirées sur la force ou la faiblesse de cette dépendance, ainsi que sur son type et son orientation. Les critères permettant de quantifier la relation entre les variables sont appelés coefficients de corrélation ou mesures de connectivité. Deux variables sont positivement corrélées s’il existe une relation directe et unidirectionnelle entre elles. Dans une relation unidirectionnelle, les petites valeurs d'une variable correspondent aux petites valeurs d'une autre variable, et les grandes valeurs correspondent aux grandes valeurs. Deux variables sont en corrélation négative entre elles s’il existe une relation inverse et multidirectionnelle entre elles. Avec une relation multidirectionnelle, les petites valeurs d'une variable correspondent aux grandes valeurs d'une autre variable et vice versa. Les valeurs des coefficients de corrélation sont toujours comprises entre -1 et +1. Le coefficient de Spearman est utilisé comme coefficient de corrélation entre les variables appartenant à une échelle ordinale, et le coefficient de corrélation de Pearson (moment des produits) est utilisé pour les variables appartenant à une échelle d'intervalle. Il faut tenir compte du fait que chaque variable dichotomique, c'est-à-dire une variable appartenant à une échelle nominale et comportant deux catégories, peut être considérée comme ordinale. Tout d’abord, nous vérifierons s’il existe une corrélation entre les variables sexuelles et psychiques du fichier studium.sav. Dans le même temps, nous tiendrons compte du fait que la variable dichotomique sexe peut être considérée comme ordinale. Suivez ces étapes: · Sélectionnez Analyser > Statistiques descriptives > Tableaux croisés dans le menu de commandes. (Tableaux de contingence) · Déplacez la variable sexe vers la liste des lignes et la variable psyché vers la liste des colonnes. · Cliquez sur le bouton Statistiques.... Dans la boîte de dialogue Tableaux croisés : Statistiques, cochez la case Corrélations. Confirmez votre sélection avec le bouton Continuer. · Dans la boîte de dialogue Tableaux croisés, désactivez l'affichage des tableaux en cochant la case Supprimer les tableaux. Cliquez sur OK. Un modèle de corrélation (CM) est un programme de calcul qui fournit une équation mathématique dans laquelle l'indicateur résultant est quantifié en fonction d'un ou plusieurs indicateurs. yx= ao+a1x1 où : y est un indicateur efficace dépendant du facteur x ; x - signe du facteur ; a1 est le paramètre CM, montrant dans quelle mesure l'indicateur effectif y changera lorsque le facteur x change de un, si tous les autres facteurs influençant y restent inchangés ; ao est un paramètre KM qui montre l'influence de tous les autres facteurs sur l'indicateur effectif y, à l'exception de la caractéristique du facteur x Lors du choix des indicateurs efficaces et factoriels du modèle, il est nécessaire de prendre en compte le fait que l'indicateur effectif dans la chaîne des relations de cause à effet se situe à un niveau supérieur aux indicateurs factoriels. Caractéristiques du modèle de corrélation Après avoir calculé les paramètres du modèle de corrélation, le coefficient de corrélation est calculé. p - coefficient de corrélation de paire, -1 ≤ p ≤ 1, montre la force et la direction de l'influence de l'indicateur factoriel sur l'indicateur résultant. Plus la connexion est proche de 1, plus la connexion est forte ; plus la connexion est proche de 0, plus la connexion est faible. Si le coefficient de corrélation est positif, alors la relation est directe ; s'il est négatif, la relation est inverse. Formule du coefficient de corrélation : pxy=(xy-x*1/y)/eh*eu hein=xx2-(x)2; y=y2-(y)2 Si le CM est multifactoriel linéaire, ayant la forme : yx= ao+a1x1+ a2x2+…+ ahpp puis un coefficient de corrélation multiple est calculé pour celui-ci. 0 ≤ P ≤ 1 et montre la force d'influence de tous les indicateurs factoriels pris ensemble sur celui qui en résulte. P = 1-((euh-ui)2/(ui -usr)2) Où : euh - indicateur effectif - valeur calculée ; ui - valeur réelle ; avr - valeur réelle, moyenne. La valeur calculée хх est obtenue en substituant x1, x2, etc. dans le modèle de corrélation. leurs valeurs réelles. Pour les modèles non linéaires monofactoriels et multifactoriels, le rapport de corrélation est calculé : 1 ≤ m ≤ 1 ; On considère que le lien entre le résultat et les indicateurs factoriels inclus dans le modèle est faible si la valeur du coefficient de proximité de connexion (m) est comprise entre 0 et 0,3 ; si 0,3-0,7 - proximité de la connexion - moyenne ; au-dessus de 0,7-1 - la connexion est forte. Puisque le coefficient de corrélation (paire) p, le coefficient de corrélation (multiple) P, le rapport de corrélation m sont des valeurs probabilistes, leurs coefficients de signification sont calculés pour elles (déterminés à partir des tableaux). Si ces coefficients sont supérieurs à leur valeur tabulaire, alors les coefficients d'étroitesse de connexion sont des raisons significatives. Si les coefficients de signification de l'étanchéité de la connexion sont inférieurs aux valeurs du tableau ou si le coefficient de connexion lui-même est inférieur à 0,7, alors tous les indicateurs factoriels qui influencent de manière significative le résultat ne sont pas inclus dans le modèle. Le coefficient de détermination montre clairement dans quel pourcentage les indicateurs factoriels inclus dans le modèle déterminent la formation du résultat. Si le coefficient de détermination est supérieur à 50, alors le modèle décrit adéquatement le processus étudié ; s'il est inférieur à 50, il est alors nécessaire de revenir à la première étape de la construction et de reconsidérer la sélection des indicateurs factoriels à inclure dans le modèle. Le coefficient de Fisher ou critère de Fisher caractérise l'efficacité du modèle dans son ensemble. Si la valeur calculée du coefficient dépasse la valeur du tableau, le modèle construit convient à l'analyse, ainsi qu'à la planification d'indicateurs et de calculs pour l'avenir. Valeur approximative du tableau = 1,5. Si la valeur calculée est inférieure à la valeur du tableau, il est nécessaire de construire d'abord un modèle incluant les facteurs qui influencent de manière significative le résultat. Outre l’efficacité du modèle dans son ensemble, chaque coefficient de régression influence la matérialité. Si la valeur calculée de ce coefficient dépasse la valeur du tableau, alors le coefficient de régression sera significatif ; s'il est inférieur, alors l'indicateur factoriel pour lequel ce coefficient a été calculé est retiré de l'échantillon et les calculs recommencent, mais sans ce facteur. . L'analyse de corrélation et de régression sont deux outils de base pour analyser des données quantitatives bivariées. Caractéristiques et tâches de l'analyse de corrélation et de régression. Analyse de corrélation. Nuage de points. Coefficient de corrélation. Interprétation du coefficient de corrélation. Analyse de régression. Équation de régression. Erreur type d’estimation. Coefficient de détermination. Si, avec un changement de la valeur de l'une des variables, la deuxième variable peut, dans certaines limites avec une certaine probabilité, prendre une valeur différente et que les caractéristiques de la deuxième variable changent selon les lois statistiques, alors une telle relation est appelé statistique. Corrélation- un concept qui définit la dépendance mutuelle de deux quantités. Une corrélation entre deux signes ou propriétés peut se produire de diverses manières. La voie principale est la dépendance causale d’une caractéristique par rapport à une autre. Une relation de corrélation est un cas particulier de relation statistique lorsque différentes valeurs d'une variable correspondent à différentes valeurs moyennes d'une autre. Par exemple, à mesure que les caractéristiques changent, la valeur de la fonction Y change. Cependant, en pratique, il peut être difficile d’identifier les causes et les effets. La corrélation étant une forme statistique, la condition principale de son étude est la nécessité de disposer d'une quantité importante de données sur un ensemble de phénomènes. On pense généralement que le nombre d'observations (statistiques) devrait être plusieurs fois supérieur (jusqu'à 10 fois) au nombre de facteurs étudiés ou pris en compte. Régression- un terme dérivé de Lat. regressio - reculer. En analyse statistique, l'analyse de régression est utilisée pour prédire une caractéristique souhaitée sur la base d'une caractéristique connue. La relation entre deux caractéristiques, exprimée explicitement, est une régression. La fonction de régression représente l'espérance mathématique de la relation et les écarts par rapport à celle-ci sont des variables aléatoires. L'analyse de corrélation-régression consiste à établir le degré de connexion (analyse de corrélation) et sa forme, c'est-à-dire expression analytique reliant les caractéristiques (analyse de régression). L'analyse de corrélation et de régression est multidimensionnelle, c'est-à-dire Un certain trait est presque toujours influencé par beaucoup d’autres. Le but de l'analyse de régression est d'évaluer la dépendance fonctionnelle de la valeur moyenne conditionnelle de la caractéristique résultante (Y) sur les facteurs factoriels (x1, x2, ..., xk). Conditions de base pour l'utilisation de la méthode de corrélation-régression 1. La présence d'un échantillon de population suffisamment large. On pense que le nombre d'observations devrait être plus de 10 fois supérieur au nombre de facteurs influençant le résultat. 2. La présence d'une population d'étude qualitativement homogène. 3. Subordination de la répartition de la population selon les caractéristiques résultantes et factorielles à la loi normale ou à la proximité de celle-ci. Le respect de cette condition est dû à l'utilisation de la méthode des moindres carrés (LSM) lors du calcul des paramètres de corrélation et de quelques autres. Principales tâches de l'analyse de corrélation et de régression 1. Mesurer l’étroitesse du lien entre la ou les caractéristiques résultantes et factorielles. En fonction du nombre de facteurs influençant le résultat, le problème est résolu en calculant le rapport de corrélation, les coefficients de corrélation double, partielle, multiple ou de détermination. 2. Estimation des paramètres de l'équation de régression exprimant la dépendance des valeurs moyennes de la caractéristique résultante sur les valeurs de la caractéristique factorielle (caractéristiques). Le problème est résolu en calculant des coefficients de régression. 3. Détermination des facteurs les plus importants influençant la caractéristique efficace. Le problème est résolu en évaluant l'étroitesse de la relation entre les facteurs et le résultat. 4. Prédiction des valeurs possibles de la caractéristique résultante étant donné les valeurs données des caractéristiques factorielles. Le problème est résolu en substituant les valeurs attendues des facteurs dans l'équation de régression L'équation de régression, ou modèle statistique de la relation entre phénomènes socio-économiques, s'exprime par la fonction : Yx = f(x1, x2, …, xn), où « n » est le nombre de facteurs inclus dans le modèle ; Хi – facteurs influençant le résultat Y. Étapes d'analyse de corrélation et de régression : Analyse préliminaire (a priori). Collecte d'informations et son traitement primaire. Construire un modèle (équations de régression). En règle générale, cette procédure est effectuée sur un PC à l'aide de programmes standards. Évaluer l'étroitesse des relations entre les caractéristiques, estimer l'équation de régression et analyser le modèle. Prévoir l'évolution du système analysé à l'aide de l'équation de régression. À la première étape le problème de recherche est formulé, la méthodologie de mesure des indicateurs ou de collecte d'informations est déterminée, le nombre de facteurs est déterminé, les facteurs en double sont exclus ou ceux liés à un système rigidement déterminé. À la deuxième étape le volume d'unités est analysé : la population doit être suffisamment grande en termes de nombre d'unités et d'observations, le nombre de facteurs « n » doit correspondre au nombre d'observations « N ». Les données doivent être quantitativement et qualitativement homogènes. À la troisième étape la forme de la connexion et le type de fonction analytique (parabole, hyperbole, droite) sont déterminés et ses paramètres sont trouvés. À la quatrième étape La fiabilité de toutes les caractéristiques de la relation de corrélation et de l'équation de régression est évaluée à l'aide du critère de fiabilité de Fisher ou de Student, et une analyse économique et technologique des paramètres est effectuée. À la cinquième étape les valeurs possibles du résultat sont prédites sur la base des meilleures valeurs des caractéristiques factorielles incluses dans le modèle. Ici, les meilleures et les pires valeurs des facteurs et le résultat sont sélectionnés.

Ce modèle de distribution normale bidimensionnelle (champ de corrélation) nous permet de donner une interprétation graphique claire du coefficient de corrélation, car la distribution au total dépend de cinq paramètres : μ x, μ y – valeurs moyennes (attentes mathématiques) ; σ x ,σ y – écarts types des variables aléatoires X et Y et p – coefficient de corrélation, qui est une mesure de la relation entre les variables aléatoires X et Y.

Si p = 0, alors les valeurs x i , y i obtenues à partir d'une population normale bidimensionnelle sont situées sur le graphique aux coordonnées x, y dans la zone limitée par le cercle (Figure 5, a). Dans ce cas, il n’y a pas de corrélation entre les variables aléatoires X et Y et elles sont dites non corrélées. Pour une distribution normale bidimensionnelle, la non-corrélation signifie simultanément l'indépendance des variables aléatoires X et Y.

mg/l

mg/l

où n est le nombre de paires d'options comparées dans la ligne « x » et dans la ligne « y »

où n est le nombre de paires d'options comparées dans la ligne « x » et dans la ligne « y »

"

Échelle dichotomique (1/0)

Échelle de rang (ordinale)

Échelle dichotomique (1/0)

Coefficient d'association de Pearson, coefficient de contingence à quatre cellules de Pearson.

Corrélation bisériale

Échelle de rang (ordinale)

Corrélation rang-bisérial.

Coefficient de corrélation des rangs de Spearman ou de Kendall.

Intervalle et échelle absolue

Corrélation bisériale

Les valeurs de l'échelle d'intervalle sont converties en rangs et le coefficient de rang est utilisé

Coefficient de corrélation de Pearson (coefficient de corrélation linéaire)

L'analyse de corrélation et de régression sont deux outils de base pour analyser des données quantitatives bivariées.

Caractéristiques et tâches de l'analyse de corrélation et de régression.