Les données obtenues à la suite de l'expérience sont caractérisées par une variabilité, qui peut être provoquée par une erreur aléatoire : erreur de l'appareil de mesure, hétérogénéité des échantillons, etc. Après avoir collecté une grande quantité de données homogènes, l’expérimentateur doit les traiter pour en extraire le plus possible information précise sur la quantité considérée. Pour traiter de grandes quantités de données de mesure, d'observations, etc., qui peuvent être obtenues au cours d'une expérience, il est pratique d'utiliser méthodes de statistiques mathématiques.

Les statistiques mathématiques sont inextricablement liées à la théorie des probabilités, mais il existe une différence significative entre ces sciences. La théorie des probabilités utilise des distributions déjà connues de variables aléatoires, sur la base desquelles sont calculées les probabilités d'événements, les attentes mathématiques, etc. Problème de statistiques mathématiques– obtenir les informations les plus fiables sur la distribution d’une variable aléatoire sur la base de données expérimentales.

Typique directions statistiques mathématiques :

- théorie de l'échantillonnage;

- théorie de l'évaluation;

- tester des hypothèses statistiques;

- analyse de régression;

- analyse de variance.

Méthodes de statistiques mathématiques

Les méthodes d'évaluation et de test des hypothèses sont basées sur des modèles probabilistes et hyper-aléatoires d'origine des données.

Les statistiques mathématiques évaluent leurs paramètres et leurs fonctions qui représentent des caractéristiques importantes des distributions (médiane, valeur attendue, écart type, quantiles, etc.), des densités et des fonctions de distribution, etc. Des estimations ponctuelles et par intervalles sont utilisées.

Les statistiques mathématiques modernes contiennent une grande section - analyse séquentielle statistique, dans lequel il est possible de former un tableau d'observations à partir d'un seul tableau.

Les statistiques mathématiques contiennent également des informations générales théorie des tests d'hypothèses et un grand nombre de méthodes pour tester des hypothèses spécifiques(par exemple, sur la symétrie de la distribution, sur les valeurs des paramètres et des caractéristiques, sur l'accord de la fonction de distribution empirique avec une fonction de distribution donnée, l'hypothèse de test d'homogénéité (la coïncidence de caractéristiques ou de fonctions de distribution dans deux échantillons), etc.).

Réalisation enquêtes par sondage, liée à la construction de méthodes adéquates pour évaluer et tester des hypothèses, avec les propriétés de différents schémas d'échantillonnage, est une branche de la statistique mathématique qui revêt une grande importance. Les méthodes de statistiques mathématiques utilisent directement les concepts de base suivants.

Échantillon

Définition 1

Échantillonnage fait référence aux données obtenues au cours de l’expérience.

Par exemple, les résultats de la portée de vol d’une balle tirée par le même canon ou par un groupe d’armes similaires.

Fonction de distribution empirique

Note 1

Fonction de distribution vous donne la possibilité de tout exprimer les caractéristiques les plus importantes Variable aléatoire.

En statistiques mathématiques, il existe un concept théorique(pas connu à l'avance) et empirique fonctions de répartition.

La fonction empirique est déterminée en fonction de données expérimentales (données empiriques), c'est-à-dire par échantillon.

diagramme à bandes

Les histogrammes sont utilisés pour une représentation visuelle, mais plutôt approximative, d'une distribution inconnue.

diagramme à bandes est une représentation graphique de la distribution des données.

Pour obtenir un histogramme de haute qualité, respectez les points suivants : règles:

- Le nombre d’éléments de l’échantillon doit être nettement inférieur à la taille de l’échantillon.

- Les intervalles fractionnés doivent contenir un nombre suffisant d'éléments d'échantillonnage.

Si l’échantillon est très grand, l’intervalle des éléments de l’échantillon est souvent divisé en parties égales.

Moyenne de l'échantillon et variance de l'échantillon

En utilisant ces concepts, vous pouvez obtenir une estimation des caractéristiques numériques nécessaires d'une distribution inconnue sans avoir recours à la construction d'une fonction de distribution, d'un histogramme, etc.

* ce travail n'est pas un ouvrage scientifique, n'est pas un ouvrage final qualifiant et est le résultat du traitement, de la structuration et du formatage des informations collectées destinées à être utilisées comme source de matériel pour auto-apprentissageœuvres pédagogiques.

Introduction.

Les références.

Méthodes de statistiques mathématiques

Introduction.

Concepts de base des statistiques mathématiques.

Traitement statistique des résultats de recherches psychologiques et pédagogiques.

Les références.

Méthodes de statistiques mathématiques

Introduction.

Concepts de base des statistiques mathématiques.

Traitement statistique des résultats de recherches psychologiques et pédagogiques.

Les références.

Introduction.

L’application des mathématiques à d’autres sciences n’a de sens qu’en unité avec une théorie profonde d’un phénomène spécifique. Il est important de s’en souvenir pour ne pas tomber dans un simple jeu de formules, sans véritable contenu derrière.

L'académicien Yu.A. Métropolitain

Les méthodes de recherche théorique en psychologie et en pédagogie permettent de révéler les caractéristiques qualitatives des phénomènes étudiés. Ces caractéristiques seront plus complètes et plus profondes si le matériel empirique accumulé est soumis à un traitement quantitatif. Cependant, le problème des mesures quantitatives dans le cadre de la recherche psychologique et pédagogique est très complexe. Cette complexité réside avant tout dans la diversité subjective-causale de l'activité pédagogique et de ses résultats, dans l'objet même de mesure, qui est dans un état de mouvement et de changement continus. Dans le même temps, l'introduction d'indicateurs quantitatifs dans la recherche est aujourd'hui une composante nécessaire et obligatoire pour obtenir des données objectives sur les résultats du travail d'enseignement. En règle générale, ces données peuvent être obtenues à la fois par mesure directe ou indirecte de diverses composantes du processus pédagogique et par évaluation quantitative des paramètres correspondants d'un modèle mathématique correctement construit. À cette fin, des méthodes de statistiques mathématiques sont utilisées lors de l'étude de problèmes de psychologie et de pédagogie. Avec leur aide, diverses tâches sont résolues : traiter des éléments factuels, obtenir de nouvelles données supplémentaires, justifier l'organisation scientifique de la recherche, etc.

2. Concepts de base des statistiques mathématiques

Un rôle extrêmement important dans l'analyse de nombreux phénomènes psychologiques et pédagogiques est joué par les valeurs moyennes, qui représentent une caractéristique généralisée d'une population qualitativement homogène selon un certain critère quantitatif. Il est impossible, par exemple, de calculer la spécialité moyenne ou la nationalité moyenne des étudiants universitaires, car il s'agit de phénomènes qualitativement hétérogènes. Mais il est possible et nécessaire de déterminer en moyenne les caractéristiques numériques de leurs performances académiques (score moyen), l'efficacité des systèmes et techniques méthodologiques, etc.

Dans la recherche psychologique et pédagogique, ils utilisent généralement différentes sortes valeurs moyennes : moyenne arithmétique, moyenne géométrique, médiane, mode et autres. Les plus courants sont la moyenne arithmétique, la médiane et le mode.

La moyenne arithmétique est utilisée dans les cas où il existe une relation directement proportionnelle entre la propriété déterminante et cette caractéristique (par exemple, lors de l'amélioration des indicateurs de performance groupe d'étude la performance de chacun de ses membres s'améliore).

La moyenne arithmétique est le quotient de la somme des quantités divisée par leur nombre et est calculée à l'aide de la formule :

où X est la moyenne arithmétique ; X1, X2, X3 ... Xn - résultats d'observations individuelles (techniques, actions),

n - nombre d'observations (techniques, actions),

La somme des résultats de toutes les observations (techniques, actions).

La médiane (Me) est une mesure de position moyenne qui caractérise la valeur d'une caractéristique sur une échelle ordonnée (basée sur une augmentation ou une diminution), qui correspond au milieu de la population étudiée. La médiane peut être déterminée pour les caractéristiques ordinales et quantitatives. L'emplacement de cette valeur est déterminé par la formule : Emplacement médian = (n + 1) / 2

Par exemple. Selon les résultats de l’étude, il a été constaté que :

– 5 personnes parmi celles participant à l'expérimentation étudient « excellemment » ;

– 18 personnes étudient « bien » ;

– « satisfaisant » – 22 personnes ;

– « insatisfaisant » – 6 personnes.

Puisqu’un total de N = 54 personnes ont participé à l’expérience, le milieu de l’échantillon est égal à une personne. On en conclut que plus de la moitié des étudiants étudient en dessous de la note « bonne », c'est-à-dire que la médiane est plus « satisfaisante », mais moins que « bonne » (voir figure).

Le mode (Mo) est la valeur typique la plus courante d'une caractéristique parmi d'autres valeurs. Elle correspond à la classe avec la fréquence maximale. Cette classe est appelée valeur modale.

Par exemple.

Si la question de l’enquête : « indiquez le degré de compétence une langue étrangère», les réponses ont été distribuées :

1 – courant – 25

2 – Je parle suffisamment pour communiquer – 54

3 – Je parle, mais j’ai du mal à communiquer – 253

4 – Je comprends difficilement – 173

5 – Je ne sais pas – 28

Évidemment, la signification la plus typique ici est « Je le possède, mais j'ai des difficultés à communiquer », qui sera modale. Le mode est donc – 253.

Lors de l'utilisation de méthodes mathématiques dans la recherche psychologique et pédagogique, une grande importance est accordée au calcul de la dispersion et des écarts types.

La dispersion est égale au carré moyen des écarts de la valeur des options par rapport à la valeur moyenne. Il s'agit de l'une des caractéristiques des résultats individuels de la dispersion des valeurs de la variable étudiée (par exemple, les notes des étudiants) autour de la valeur moyenne. Le calcul de la dispersion s'effectue en déterminant : l'écart par rapport à la valeur moyenne ; le carré de l'écart spécifié ; la somme des écarts carrés et la valeur moyenne de l'écart carré (voir tableau 6.1).

La valeur de la variance est utilisée dans divers calculs statistiques, mais n'est pas directement observable. La valeur directement liée au contenu de la variable observée est l'écart type.

Tableau 6.1

Exemple de calcul d'écart

|

Signification indicateur |

Déviation de la moyenne |

écarts |

|

|

2 – 3 = – 1 |

|||

L'écart type confirme la typicité et le caractère indicatif de la moyenne arithmétique et reflète la mesure de la fluctuation des valeurs numériques des caractéristiques à partir desquelles est dérivée la valeur moyenne. Elle est égale à la racine carrée de la variance et est déterminée par la formule :

où : – carré moyen. Si le nombre d'observations (actions) est faible (inférieur à 100) dans la valeur de la formule, vous ne devez pas mettre « N », mais « N – 1 ».

La moyenne arithmétique et la moyenne quadratique sont les principales caractéristiques des résultats obtenus au cours de l'étude. Ils permettent de résumer les données, de les comparer et d'établir les avantages d'un système (programme) psychologique et pédagogique par rapport à un autre.

L’écart quadratique moyen (type) est largement utilisé comme mesure de dispersion pour diverses caractéristiques.

Lors de l'évaluation des résultats d'une étude, il est important de déterminer la dispersion d'une variable aléatoire autour de la valeur moyenne. Cette dispersion est décrite à l'aide de la loi de Gaus (loi distribution normale probabilité d'une variable aléatoire). L'essence de la loi est que lors de la mesure d'une certaine caractéristique dans un ensemble d'éléments donné, il y a toujours des écarts dans les deux sens par rapport à la norme en raison de nombreuses raisons incontrôlables, et plus les écarts sont importants, moins ils se produisent.

Le traitement ultérieur des données peut révéler : coefficient de variation (stabilité) le phénomène étudié, qui est le rapport en pourcentage de l'écart type à la moyenne arithmétique ; mesure d'obliquité, montrant dans quelle direction sont dirigés la majorité des déviations ; mesure de fraîcheur, qui montre le degré d'accumulation de valeurs de variables aléatoires autour de la moyenne, etc. Toutes ces données statistiques permettent de mieux identifier les signes des phénomènes étudiés.

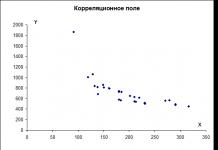

Mesures des relations entre variables. Les relations (dépendances) entre deux ou plusieurs variables dans les statistiques sont appelées corrélation. Elle est évaluée à l’aide de la valeur du coefficient de corrélation, qui mesure le degré et l’ampleur de cette relation.

Il existe de nombreux coefficients de corrélation. Considérons seulement quelques-uns d'entre eux, qui prennent en compte la présence d'une relation linéaire entre les variables. Leur choix dépend des échelles de mesure des variables dont il convient d'évaluer la relation entre elles. Les coefficients de Pearson et Spearman sont le plus souvent utilisés en psychologie et en pédagogie.

Examinons le calcul des valeurs des coefficients de corrélation à l'aide d'exemples spécifiques.

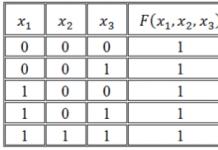

Exemple 1. Soit deux variables comparées X (état civil) et Y (exclusion de l'université) mesurées sur une échelle dichotomique (un cas particulier de l'échelle des noms). Pour déterminer la relation, nous utilisons le coefficient de Pearson.

Dans les cas où il n'est pas nécessaire de compter la fréquence d'apparition de différentes valeurs des variables X et Y, il est pratique de calculer le coefficient de corrélation à l'aide d'un tableau de contingence (voir tableaux 6.2, 6.3, 6.4), montrant le nombre d'occurrences conjointes de paires de valeurs pour deux variables (caractéristiques) . A – le nombre de cas où la variable X a une valeur égal à zéro, et en même temps la variable Y a la valeur égal à un; B est le nombre de cas où les variables X et Y ont simultanément des valeurs égales à un ; C – le nombre de cas où les variables X et Y ont simultanément des valeurs égales à zéro ; D – le nombre de cas où la variable X a une valeur égale à un et, en même temps, la variable Y a une valeur égale à zéro.

Tableau 6.2

Tableau de contingence général

|

Signe X |

||||

En général, la formule du coefficient de corrélation de Pearson pour les données dichotomiques a la forme

Tableau 6.3

Exemple de données sur une échelle dichotomique

Remplaçons dans la formule les données du tableau de contingence (voir tableau 6.4) correspondant à l'exemple considéré :

Ainsi, le coefficient de corrélation de Pearson pour l'exemple sélectionné est de 0,32, c'est-à-dire que la relation entre l'état civil des étudiants et les faits d'exclusion de l'université est insignifiante.

Exemple 2 : Si les deux variables sont mesurées sur des échelles d'ordre, alors le coefficient de corrélation de rang (Rs) de Spearman est utilisé comme mesure d'association. Il est calculé par la formule

où Rs est le coefficient de corrélation de rang de Spearman ; Di – différence dans les rangs des objets comparés ; N – nombre d'objets comparés.

La valeur du coefficient de Spearman varie de –1 à + 1. Dans le premier cas, il existe une relation sans ambiguïté mais de direction opposée entre les variables analysées (à mesure que les valeurs de l'une augmentent, les valeurs de l'autre diminuent) . Dans le second, à mesure que les valeurs d'une variable augmentent, la valeur de la deuxième variable augmente proportionnellement. Si la valeur de Rs est égale à zéro ou a une valeur proche, alors il n’y a pas de relation significative entre les variables.

A titre d'exemple de calcul du coefficient de Spearman, nous utilisons les données du tableau 6.5.

Tableau 6.5

Données et résultats intermédiaires du calcul de la valeur du coefficient

corrélation de rang Rs

|

Qualités |

Rangs attribués par un expert |

Différence de classement |

Différence de rang au carré |

|

|

–1 |

||||

|

Somme des différences de rang au carré Di = 22 |

Remplaçons les données d'exemple dans la formule du coefficient de Smearman :

Les résultats du calcul permettent d'affirmer qu'il existe une relation assez prononcée entre les variables considérées.

Test statistique d'une hypothèse scientifique. La preuve de la fiabilité statistique d'un effet expérimental est très différente de la preuve en mathématiques et en logique formelle, où les conclusions sont de nature plus universelle : les preuves statistiques ne sont pas si strictes et définitives - elles comportent toujours le risque de commettre des erreurs dans les conclusions. et donc la validité de l'un ou l'autre n'est pas finalement prouvée par des méthodes statistiques conclusion, mais montre le degré de plausibilité de l'acceptation d'une hypothèse particulière.

Une hypothèse pédagogique (hypothèse scientifique sur l'avantage d'une méthode particulière, etc.) dans le processus d'analyse statistique est traduite dans le langage de la science statistique et reformulée à nouveau dans au moins deux hypothèses statistiques. Le premier (principal) s'appelle hypothèse nulle(H 0), dans lequel le chercheur parle de sa position initiale. Il semble (a priori) déclarer que la nouvelle méthode (présumée par lui, ses collègues ou ses adversaires) n'a aucun avantage, et donc dès le début le chercheur est psychologiquement prêt à adopter une position scientifique honnête : les différences entre les les nouvelles et anciennes méthodes sont déclarées égales à zéro. En autre, hypothèse alternative(H 1) une hypothèse est faite sur l’avantage de la nouvelle méthode. Parfois, plusieurs hypothèses alternatives sont avancées avec les notations appropriées.

Par exemple, l'hypothèse sur l'avantage de l'ancienne méthode (H 2). Les hypothèses alternatives sont acceptées si et seulement si l’hypothèse nulle est rejetée. Cela se produit dans les cas où les différences, par exemple, dans les moyennes arithmétiques des groupes expérimentaux et témoins sont si significatives (statistiquement significatives) que le risque d'erreur en rejetant l'hypothèse nulle et en acceptant l'alternative ne dépasse pas un sur trois accepté. niveaux de signification sortie statistique :

– premier niveau – 5% (dans les textes scientifiques, on écrit parfois p = 5% ou a? 0,05, s'il est présenté en fractions), où le risque d'erreur dans la conclusion est admis dans cinq cas sur cent expériences similaires théoriquement possibles avec une sélection strictement aléatoire de sujets pour chaque expérience ;

– deuxième niveau – 1%, c'est-à-dire que le risque de se tromper n'est autorisé que dans un cas sur cent (a 0,01, avec les mêmes exigences) ;

– troisième niveau – 0,1%, c'est-à-dire le risque de se tromper n'est autorisé que dans un cas sur mille (a ? 0,001). Le dernier niveau de signification impose des exigences très élevées en matière de justification de la fiabilité des résultats expérimentaux et est donc rarement utilisé.

Lors de la comparaison des moyennes arithmétiques des groupes expérimentaux et témoins, il est important non seulement de déterminer quelle moyenne est la plus grande, mais également de combien. Plus la différence entre eux est petite, plus l'hypothèse nulle concernant l'absence de différences statistiquement significatives (significatives) sera acceptable. Contrairement à la pensée au niveau de la conscience ordinaire, qui tend à percevoir la différence de moyennes obtenues grâce à l'expérience comme un fait et une base de conclusion, un enseignant-chercheur familier avec la logique de l'inférence statistique ne se précipitera pas de tels cas. Il fera très probablement une hypothèse sur le caractère aléatoire des différences, avancera une hypothèse nulle sur l'absence de différences significatives dans les résultats des groupes expérimentaux et témoins, et ce n'est qu'après avoir réfuté l'hypothèse nulle qu'il en acceptera une alternative.

Ainsi, la question des différences au sein de la pensée scientifique est transférée sur un autre plan. L'important n'est pas seulement les différences (elles existent presque toujours), mais l'ampleur de ces différences et donc - la détermination de la différence et de la limite au-delà de laquelle on peut dire : oui, les différences ne sont pas aléatoires, elles sont statistiquement significatives. , ce qui signifie que les sujets de ces deux groupes appartiennent après l'expérimentation non plus à une (comme avant), mais à deux populations générales différentes et que le niveau de préparation des étudiants potentiellement appartenant à ces populations sera significativement différent. Afin de montrer les limites de ces différences, ce qu'on appelle estimations des paramètres généraux.

Examinons un exemple spécifique (voir tableau 6.6) montrant comment, à l'aide de statistiques mathématiques, vous pouvez réfuter ou confirmer l'hypothèse nulle.

Disons qu’il faut déterminer si l’efficacité des activités de groupe des étudiants dépend du niveau de développement du groupe d’étude. les relations interpersonnelles. L’hypothèse nulle est l’hypothèse selon laquelle une telle dépendance n’existe pas, et l’hypothèse alternative est que la dépendance existe. À ces fins, les résultats de l'efficacité des activités de deux groupes sont comparés, dont l'un fait dans ce cas office de groupe expérimental et le second de groupe témoin. Pour déterminer si la différence entre les indicateurs de performance moyens des premier et deuxième groupes est significative (significative), il est nécessaire de calculer la signification statistique de cette différence. Pour ce faire, vous pouvez utiliser le test t de Student. Il est calculé par la formule :

où X 1 et X 2 sont la moyenne arithmétique des variables des groupes 1 et 2 ; M 1 et M 2 sont les valeurs des erreurs moyennes, qui sont calculées à l'aide de la formule :

où est la moyenne quadratique, calculée à l'aide de la formule (2).

Déterminons les erreurs pour la première ligne (groupe expérimental) et la deuxième ligne (groupe témoin) :

On trouve la valeur de t - critère à l'aide de la formule :

Après avoir calculé la valeur du critère t, il est nécessaire d'utiliser un tableau spécial pour déterminer le niveau de signification statistique des différences entre les indicateurs de performance moyens dans les groupes expérimentaux et témoins. Plus la valeur du critère t est élevée, plus les différences sont significatives.

Pour ce faire, nous comparons le t calculé avec le t tabulé. La valeur du tableau est choisie en tenant compte du niveau de confiance choisi (p = 0,05 ou p = 0,01), ainsi qu'en fonction du nombre de degrés de liberté, qui est trouvé par la formule :

où U est le nombre de degrés de liberté ; N 1 et N 2 – le nombre de mesures dans les première et deuxième lignes. Dans notre exemple, U = 7 + 7 –2 = 12.

Tableau 6.6

Données et résultats intermédiaires du calcul de la signification statistique

Différences de valeurs moyennes

|

Groupe expérimental |

Groupe de contrôle |

|||||

|

L’importance de l’efficacité opérationnelle |

||||||

Pour le tableau des critères t, nous constatons que la valeur du tableau t. = 3,055 pour le niveau de un pour cent (p

Cependant, l'enseignant-chercheur doit rappeler que l'existence d'une signification statistique de la différence des valeurs moyennes est un argument important, mais pas le seul, en faveur de la présence ou de l'absence de relation (dépendance) entre phénomènes ou variables. Il est donc nécessaire d’inclure d’autres arguments pour justifier quantitativement ou substantiellement un éventuel lien.

Méthodes multivariées d'analyse des données. L'analyse de la relation entre un grand nombre de variables est réalisée à l'aide de méthodes de traitement statistique multivarié. Le but de l’utilisation de telles méthodes est de rendre visibles les modèles cachés et de mettre en évidence les relations les plus significatives entre les variables. Des exemples de telles méthodes statistiques multivariées sont :

- analyse factorielle;

- l'analyse par grappes;

– analyse de variance ;

- analyse de régression;

– analyse structurelle latente ;

– mise à l'échelle multidimensionnelle et autres.

Analyse factorielle est d’identifier et d’interpréter les facteurs. Un facteur est une variable généralisée qui permet de réduire une partie de l'information, c'est-à-dire de la présenter sous une forme facilement compréhensible. Par exemple, la théorie factorielle de la personnalité identifie un certain nombre de caractéristiques comportementales généralisées, appelées dans ce cas traits de personnalité.

L'analyse par grappes vous permet d'identifier la fonctionnalité principale et la hiérarchie des relations entre les fonctionnalités.

Analyse de variance– une méthode statistique utilisée pour étudier une ou plusieurs variables opérant simultanément et indépendantes pour la variabilité d’une caractéristique observée. Sa particularité est que le trait observé ne peut être que quantitatif, alors qu'en même temps les traits explicatifs peuvent être à la fois quantitatifs et qualitatifs.

Analyse de régression nous permet d'identifier la dépendance quantitative (numérique) de la valeur moyenne des changements de la caractéristique résultante (expliquée) sur les changements d'une ou plusieurs caractéristiques (variables explicatives). En règle générale, ce type d'analyse est utilisé lorsqu'il est nécessaire de déterminer dans quelle mesure la valeur moyenne d'une caractéristique change lorsqu'une autre caractéristique change d'une unité.

Analyse de la structure latente représente un ensemble de procédures analytiques et statistiques pour identifier les variables cachées (signes), ainsi que structure interne liens entre eux. Il permet d'étudier les manifestations de relations complexes entre des caractéristiques directement inobservables de phénomènes socio-psychologiques et pédagogiques. L'analyse latente peut servir de base à la modélisation de ces relations.

Échelle multidimensionnelle fournit une évaluation visuelle des similitudes ou des différences entre certains objets décrits par un grand nombre de variables différentes. Ces différences sont représentées sous forme de distances entre les objets évalués dans un espace multidimensionnel.

3. Traitement statistique des résultats des études psychologiques et pédagogiques

recherche

Dans toute étude, il est toujours important de garantir l’ampleur et la représentativité des objets d’étude. Pour résoudre ce problème, ils recourent généralement à des méthodes mathématiques de calcul de la taille minimale des objets à étudier (groupes de répondants), afin que des conclusions objectives puissent être tirées sur cette base.

Sur la base du degré d'exhaustivité de la couverture des unités primaires, les statistiques divisent la recherche en continue, lorsque toutes les unités du phénomène étudié sont étudiées, et sélective, lorsque seule une partie de la population d'intérêt, prise selon certaines caractéristiques, est étudiée. . Le chercheur n'a pas toujours la possibilité d'étudier l'ensemble des phénomènes, même s'il faut constamment s'yefforcer (il n'y a pas assez de temps, de fonds, de conditions nécessaires, etc.) ; d'un autre côté, une étude complète n'est souvent tout simplement pas nécessaire, car les conclusions seront assez précises après avoir étudié une certaine partie des unités primaires.

La base théorique de la méthode de recherche par échantillonnage est la théorie des probabilités et la loi grands nombres. Pour que l'étude comporte un nombre suffisant de faits et d'observations, un tableau de nombres suffisamment grands est utilisé. Dans ce cas, le chercheur doit établir l'ampleur de la probabilité et l'ampleur de l'erreur tolérée. Supposons, par exemple, que l'erreur tolérée dans les conclusions qui devraient être tirées à la suite d'observations, par rapport aux hypothèses théoriques, ne dépasse pas 0,05 dans les sens positif et négatif (en d'autres termes, nous ne pouvons nous tromper que de plus de 5 cas sur 100). Ensuite, d'après le tableau des nombres suffisamment grands (voir tableau 6.7), on constate que la conclusion correcte peut être tirée dans 9 cas sur 10 lorsque le nombre d'observations est d'au moins 270, dans 99 cas sur 100 lorsqu'il y a au moins 663 observations, etc. d. Cela signifie qu'à mesure que la précision et la probabilité avec lesquelles nous espérons tirer des conclusions augmentent, le nombre d'observations requises augmente. Cependant, dans la recherche psychologique et pédagogique, elle ne devrait pas être excessivement importante. 300 à 500 observations suffisent souvent pour tirer des conclusions solides.

Cette méthode de détermination de la taille de l’échantillon est la plus simple. Les statistiques mathématiques disposent également de méthodes plus complexes pour calculer les échantillons de population requis, qui sont traitées en détail dans la littérature spécialisée.

Cependant, le respect des exigences de masse ne garantit pas encore la fiabilité des conclusions. Ils seront fiables lorsque les unités choisies pour l'observation (conversations, expériences, etc.) seront suffisamment représentatives de la classe de phénomènes étudiés.

Tableau 6.7

Un petit tableau de nombres suffisamment grands

|

Ordre de grandeur probabilités Acceptable |

||||||

La représentativité des unités d'observation est assurée principalement par leur sélection aléatoire à l'aide de tables de nombres aléatoires. Disons que nous devons identifier 20 groupes d'étude pour mener une expérience de masse parmi les 200 disponibles. Pour ce faire, une liste de tous les groupes est dressée, qui est numérotée. Ensuite, 20 nombres sont écrits à partir de la table de nombres aléatoires, en commençant par un certain nombre, à un certain intervalle. Ces 20 nombres aléatoires, en fonction des nombres, déterminent les groupes dont le chercheur a besoin. Une sélection aléatoire d'objets de la population générale (générale) permet d'affirmer que les résultats obtenus en étudiant un échantillon de population d'unités ne différeront pas fortement de ceux qui existeraient dans le cas de l'étude de l'ensemble de la population d'unités.

Dans la pratique de la recherche psychologique et pédagogique, on utilise non seulement des sélections aléatoires simples, mais également des méthodes de sélection plus complexes : sélection aléatoire stratifiée, sélection en plusieurs étapes, etc.

Mathématiques et Méthodes statistiques La recherche est également un moyen d’obtenir de nouveaux éléments factuels. À cette fin, des techniques de modèles sont utilisées qui augmentent la capacité informative de la question et de la mise à l'échelle du questionnaire, ce qui permet d'évaluer plus précisément les actions du chercheur et des sujets.

Les échelles sont nées de la nécessité de diagnostiquer et de mesurer objectivement et précisément l'intensité de certains phénomènes psychologiques et pédagogiques. La mise à l'échelle permet d'organiser les phénomènes, de quantifier chacun d'eux et de déterminer les niveaux les plus bas et les plus élevés du phénomène étudié.

Ainsi, lorsqu'on étudie les intérêts cognitifs des auditeurs, leurs limites peuvent être établies : intérêt très fort - intérêt très faible. Entre ces frontières, introduire une série d'étapes créant une échelle d'intérêts cognitifs : très grand intérêt (1) ; grand intérêt (2); moyen (3); faible (4); très faible (5).

Dans la recherche psychologique et pédagogique, des échelles de différents types sont utilisées, par exemple :

a) Échelle tridimensionnelle

Très actif……..…………..10

Actif…………………………5

Passif………………………...0

b) Échelle multidimensionnelle

Très actif…………………..8

Moyennement actif………………….6

Pas trop actif…………...4

Passif………………………..2

Complètement passif…………...0

c) Échelle bilatérale.

Très intéressé……………..10

Assez intéressé………...5

Indifférent……………………….0

Pas intéressé…………………..5

Aucun intérêt du tout………10

Les échelles de notation numérique donnent à chaque élément une désignation numérique spécifique. Ainsi, lorsqu’on analyse les attitudes des étudiants à l’égard des études, leur persévérance dans le travail, leur volonté de coopérer, etc. vous pouvez créer une échelle numérique basée sur les indicateurs suivants : 1 – insatisfaisant ; 2 – faible ; 3 – moyen ; 4 – au-dessus de la moyenne, 5 – bien au-dessus de la moyenne. Dans ce cas, l'échelle prend la forme suivante (voir tableau 6.8) :

Tableau 6.8

Si l'échelle numérique est bipolaire, un ordre bipolaire avec une valeur nulle au centre est utilisé :

Discipline Indiscipline

Prononcé 5 4 3 2 1 0 1 2 3 4 5 Non prononcé

Les échelles de notation peuvent être représentées graphiquement. Dans ce cas, ils expriment les catégories sous une forme visuelle. De plus, chaque division (étape) de l'échelle est caractérisée verbalement.

Les méthodes considérées jouent un rôle important dans l'analyse et la synthèse des données obtenues. Ils permettent d'établir diverses relations, corrélations entre faits, et d'identifier des tendances dans l'évolution des phénomènes psychologiques et pédagogiques. Ainsi, la théorie des regroupements de statistiques mathématiques aide à déterminer quels faits du matériel empirique collecté sont comparables, sur quelle base ils doivent être correctement regroupés et quel degré de fiabilité ils auront. Tout cela permet d'éviter les manipulations arbitraires des faits et de déterminer un programme pour les traiter. Selon les buts et objectifs, trois types de regroupements sont généralement utilisés : typologique, variationnel et analytique.

Regroupement typologique utilisé lorsqu'il est nécessaire de diviser le reçu matériel factuel en unités qualitativement homogènes (répartition du nombre d'infractions à la discipline entre les différentes catégories d'étudiants, répartition des indicateurs de leur performance aux exercices physiques par année d'études, etc.).

S'il est nécessaire de regrouper le matériel en fonction de la valeur de tout attribut changeant (variable) - répartition des groupes d'étudiants par niveau de performance, pourcentage de devoirs terminés, violations similaires de l'ordre établi, etc. – s'applique regroupement de variantes, ce qui permet de juger de manière cohérente la structure du phénomène étudié.

Vue analytique du regroupement permet d'établir la relation entre les phénomènes étudiés (la dépendance du degré de préparation des étudiants aux différentes méthodes d'enseignement, la qualité des tâches exécutées sur le tempérament, les capacités, etc.), leur interdépendance et leur interdépendance en termes précis.

L'importance du travail du chercheur dans le regroupement des données collectées est démontrée par le fait que les erreurs dans ce travail dévalorisent l'information la plus complète et la plus significative.

Actuellement, les fondements mathématiques du regroupement, de la typologie et de la classification ont reçu le développement le plus profond en sociologie. Approches modernes et les méthodes de typologie et de classification utilisées dans la recherche sociologique peuvent être appliquées avec succès en psychologie et en pédagogie.

Au cours de l'étude, des méthodes de synthèse finale des données sont utilisées. L'un d'eux est la technique de compilation et d'étude des tableaux.

Lors de la compilation d'un résumé des données concernant une valeur statistique, une série de distribution (série de variations) de la valeur de cette valeur est formée. Un exemple d'une telle série (voir tableau 6.9) est un résumé des données concernant le tour de poitrine de 500 individus.

Tableau 6.9

Le résumé des données simultanément pour deux ou plusieurs grandeurs statistiques implique l'élaboration d'un tableau de distribution qui révèle la distribution des valeurs d'une grandeur statique en fonction des valeurs prises par d'autres grandeurs.

A titre d'illustration, le tableau 6.10 est fourni, établi sur la base de données statistiques concernant le tour de poitrine et le poids de ces personnes.

Tableau 6.10

|

Tour de poitrine en cm |

|||||||||||

Le tableau de répartition donne une idée de la relation et du lien qui existe entre les deux valeurs, à savoir : avec un faible poids, les fréquences se situent dans le quart supérieur gauche du tableau, ce qui indique la prédominance des individus ayant un petit tour de poitrine . À mesure que le poids augmente jusqu'à la valeur moyenne, la distribution des fréquences se déplace vers le centre de la plaque. Cela indique que les personnes dont le poids est plus proche de la moyenne ont un tour de poitrine également proche de la moyenne. Avec une nouvelle augmentation de poids, les fréquences commencent à occuper le quart inférieur droit de la plaque. Cela indique qu’une personne qui pèse au-dessus de la moyenne a également un tour de poitrine supérieur à la moyenne.

Il résulte du tableau que la connexion établie n'est pas stricte (fonctionnelle), mais probabiliste, lorsqu'avec des changements dans les valeurs d'une quantité, une autre change comme une tendance, sans dépendance stricte et sans ambiguïté. Des connexions et dépendances similaires se retrouvent souvent en psychologie et en pédagogie. Actuellement, ils sont généralement exprimés à l’aide d’analyses de corrélation et de régression.

Les séries de variations et les tableaux donnent une idée de la statique d'un phénomène, tandis que la dynamique peut être montrée par des séries de développement, où la première ligne contient des étapes ou des intervalles de temps successifs, et la seconde - les valeurs de la valeur statistique étudiée à ces étapes. De cette façon, les augmentations, les diminutions ou les changements périodiques du phénomène étudié sont révélés, ainsi que ses tendances et modèles.

Les tableaux peuvent être remplis de valeurs absolues ou de chiffres récapitulatifs (moyens, relatifs). Les résultats du travail statistique - en plus des tableaux, sont souvent représentés graphiquement sous forme de diagrammes, de figures, etc. Les principales méthodes de représentation graphique des grandeurs statistiques sont : la méthode des points, la méthode des droites et la méthode des rectangles . Ils sont simples et accessibles à tout chercheur. La technique pour les utiliser consiste à tracer des axes de coordonnées, à établir une échelle et à écrire les désignations des segments (points) sur les axes horizontal et vertical.

Les diagrammes représentant des séries de distributions de valeurs d'une grandeur statistique permettent de tracer des courbes de distribution.

La représentation graphique de deux (ou plusieurs) grandeurs statistiques permet de former une certaine surface courbe, appelée surface de distribution. La série d'évolutions dans l'exécution graphique forme des courbes de développement.

Une représentation graphique du matériel statistique permet d'approfondir la signification des grandeurs numériques, de saisir leurs interdépendances et les caractéristiques du phénomène étudié, difficiles à remarquer dans le tableau. Le chercheur est libéré du travail qu’il devrait accomplir pour comprendre l’abondance des nombres.

Les tableaux et les graphiques sont importants, mais ne constituent que les premières étapes de l'étude des quantités statistiques. La méthode principale est analytique, fonctionnant avec des formules mathématiques, à l'aide desquelles sont dérivés ce que l'on appelle les « indicateurs généralisants », c'est-à-dire valeurs absolues, présentés sous une forme comparable (valeurs relatives et moyennes, soldes et indices). Ainsi, à l'aide de valeurs relatives (pourcentages), les caractéristiques qualitatives des populations analysées sont déterminées (par exemple, le ratio d'excellents étudiants par rapport au nombre total d'étudiants ; le nombre d'erreurs lors du travail sur des équipements complexes causées par l'instabilité mentale de élèves au nombre total d’erreurs, etc.). C'est-à-dire que les relations sont révélées : les parties au tout (densité spécifique), les composants à la somme (structure de la totalité), une partie de la totalité à son autre partie ; caractériser la dynamique de tout changement dans le temps, etc.

Comme vous pouvez le constater, même la compréhension la plus générale des méthodes de calcul statistique suggère que ces méthodes ont de grandes capacités dans l'analyse et le traitement du matériel empirique. Bien entendu, l’appareil mathématique peut traiter sans passion tout ce qu’un chercheur y met, qu’il s’agisse de données fiables ou de spéculations subjectives. C'est pourquoi la maîtrise parfaite de l'appareil mathématique de traitement du matériel empirique accumulé, alliée à une connaissance approfondie des caractéristiques qualitatives du phénomène étudié, est nécessaire pour tout chercheur. Ce n'est que dans ce cas qu'il est possible de sélectionner des éléments factuels objectifs et de haute qualité, de les traiter de manière qualifiée et d'obtenir des données finales fiables.

Ceci est une brève description des méthodes les plus couramment utilisées pour étudier les problèmes en psychologie et en pédagogie. Il convient de souligner qu'aucune des méthodes considérées, prise à elle seule, ne peut prétendre à l'universalité ou à une garantie complète de l'objectivité des données obtenues. Ainsi, les éléments de subjectivité dans les réponses obtenues par les personnes interrogées sont évidents. En règle générale, les résultats des observations ne sont pas exempts des évaluations subjectives du chercheur lui-même. Les données extraites de diverses documentations nécessitent simultanément une vérification de l'exactitude de cette documentation (notamment documents personnels, documents d'occasion, etc.).

Par conséquent, chaque chercheur doit s'efforcer, d'une part, d'améliorer la technique d'utilisation de toute méthode spécifique et, d'autre part, d'utiliser de manière complexe et mutuellement contrôlée différentes méthodes pour étudier le même problème. La maîtrise de l'ensemble du système de méthodes permet d'élaborer une méthodologie de recherche rationnelle, de l'organiser et de la conduire clairement, et d'obtenir des résultats théoriques et pratiques significatifs.

Les références.

Chevandrin N.I. La psychologie sociale dans l'éducation: Didacticiel. Partie 1. Fondements conceptuels et appliqués de la psychologie sociale. – M. : VLADOS, 1995.

2. Davydov V.P. Fondements de la méthodologie, des méthodes et de la technologie de la recherche pédagogique : Manuel scientifique et méthodologique. – M. : Académie FSB, 1997.

Département de biophysique, d'informatique et d'équipement médical de l'Université nationale de médecine d'Odessa Des lignes directricesÉtudiants de 1ère année sur le thème « Fondamentaux de la statistique mathématique » Odessa 20091. Sujet : « Fondamentaux de la statistique mathématique ».

2. Pertinence du sujet.

Les statistiques mathématiques sont une branche des mathématiques qui étudie les méthodes de collecte, de systématisation et de traitement des résultats d'observations de masse. événements aléatoires afin de clarifier et application pratique modèles existants. Les méthodes de statistiques mathématiques ont trouvé de nombreuses applications en médecine clinique et en soins de santé. Ils sont utilisés notamment dans le développement de méthodes mathématiques de diagnostic médical, dans la théorie des épidémies, dans la planification et le traitement des résultats d'une expérience médicale, dans l'organisation des soins de santé. Les concepts statistiques sont utilisés, consciemment ou inconsciemment, dans la prise de décision dans des domaines tels que le diagnostic clinique, la prévision de l'évolution de la maladie chez un patient individuel, la prévision du résultat probable des programmes dans une population donnée et la sélection du programme approprié dans des circonstances particulières. La connaissance des idées et des méthodes des statistiques mathématiques est un élément nécessaire enseignement professionnel chaque agent de santé.

3. Des cours entiers. L'objectif général de la leçon est d'apprendre aux étudiants à utiliser consciemment les statistiques mathématiques lors de la résolution de problèmes de profil biomédical. Cours entiers spécifiques :- familiariser les étudiants avec les idées, concepts et méthodes de base de la statistique mathématique, en accordant une attention particulière aux questions liées au traitement des résultats des observations d'événements aléatoires de masse afin de clarifier et d'appliquer pratiquement les modèles existants ;

- apprendre aux élèves à appliquer consciemment les concepts de base des statistiques mathématiques lors de la résolution de problèmes simples qui se posent dans activité professionnelle médecin

- détermination de la fréquence des cours (absolue et relative)

- détermination du granulat général et échantillonnage, volume d'échantillonnage

- estimation de points et d'intervalles

- intervalle fiable et fiabilité

- définition du mode, de la médiane et de la moyenne de l'échantillon

- définition de l'intervalle, intervalle interquartile, écart quartile

- détermination de l'écart absolu moyen

- détermination de la covariance et de la variance de l'échantillon

- détermination de l'écart type de l'échantillon et du coefficient de variation

- détermination des coefficients de régression d'échantillon

- équations empiriques de régression linéaire

- détermination du coefficient de corrélation de l'échantillon.

- mode, médiane et moyenne de l'échantillon

- intervalle, intervalle interquartile, écart quartile

- signifie une déviation absolue

- covariance et variance de l'échantillon

- écart type de l'échantillon et coefficient de variation

- intervalle fiable pour l'espérance et la variance

- échantillons de coefficients de régression

- coefficient de corrélation de l'échantillon.

- Définition de la distribution, des séries de distribution et de la distribution multi-nœuds d'une variable aléatoire discrète

- Détermination de la variation fonctionnelle entre variables aléatoires

- Détermination de la corrélation entre variables aléatoires

- Définition d'un événement flash, de sa fréquence relative et de sa probabilité.

- Théorème pour composer les probabilités d'événements incompatibles

- Théorème de compilation des probabilités d'événements conjoints

- Théorème de multiplication des probabilités d'événements indépendants

- Théorème de multiplication des probabilités d'événements dépendants

- Théorème de probabilité totale

- Théorème de Bayes

- Définition des variables aléatoires : discrètes et continues

- Définition de la distribution, des séries de distribution et du polygone de distribution d'une variable aléatoire discrète

- Définition de la fonction de distribution

- Définition des mesures de position du centre de distribution

- Détermination de mesures de variabilité de valeurs de variables aléatoires

- Détermination de l'épaisseur de la distribution et de la courbe de distribution d'une variable aléatoire continue

- Détermination de la dépendance fonctionnelle entre variables aléatoires

- Détermination de la corrélation entre des variables aléatoires

- Définition de régression, équation et droites de régression

- Détermination de la covariance et du coefficient de corrélation

- Définition de l'équation de régression linéaire.

- Zhumatiy P.G. Conférence « Théorie des probabilités ». Odessa, 2009.

- Zhumatiy P.G. « Fondamentaux de la théorie des probabilités ». Odessa, 2009.

- Zhumatiy P.G., Senitska Y.R. Éléments de théorie des probabilités. Lignes directrices pour les étudiants des instituts de médecine. Odessa, 1981.

- Chaly O.V., Agapov B.T., Tsekhmister Y.V. Physique médicale et biologique. Kyiv, 2004.

Les statistiques mathématiques sont une branche des mathématiques qui étudie les méthodes de collecte, de systématisation, de traitement, de représentation, d'analyse et d'interprétation des résultats d'observation afin d'identifier les modèles existants.

L’utilisation des statistiques dans les soins de santé est nécessaire tant au niveau de la communauté qu’au niveau individuel des patients. La médecine traite d'individus qui diffèrent les uns des autres par de nombreuses caractéristiques, et les valeurs par lesquelles une personne peut être considérée comme en bonne santé varient d'un individu à l'autre. Il n'existe pas deux patients ou groupes de patients identiques, c'est pourquoi les décisions qui affectent des patients ou des populations individuelles doivent être prises sur la base de l'expérience acquise auprès d'autres patients ou populations présentant des caractéristiques biologiques similaires. Il faut comprendre que, compte tenu des divergences existantes, ces décisions ne peuvent pas être absolument exactes – elles sont toujours associées à une certaine incertitude. C’est précisément la nature virale de la médecine.

Quelques exemples d’application des méthodes statistiques en médecine :

interprétation de la variation (la variabilité des caractéristiques d'un organisme pour décider quelle valeur de telle ou telle caractéristique sera idéale, normale, moyenne, etc., nécessite l'utilisation de méthodes statistiques appropriées).

diagnostic des maladies chez des patients individuels et évaluation de l'état de santé d'un groupe de population.

prédire la fin d'une maladie chez des patients individuels ou le résultat possible d'un programme de contrôle d'une maladie particulière dans n'importe quel groupe de population.

sélectionner une influence appropriée sur un patient ou un groupe de population.

planifier et mener des recherches médicales, analyser et publier les résultats, les lire et les évaluer de manière critique.

planification et gestion des soins de santé.

Les informations utiles sur la santé sont généralement cachées dans des masses de données brutes. Il est nécessaire de concentrer les informations qu'ils contiennent et de présenter les données de manière à ce que la structure de variation soit clairement visible, puis de sélectionner des méthodes d'analyse spécifiques.

La présentation des données fournit une introduction aux concepts et termes suivants :

série de variations (arrangement ordonné) - un arrangement simple d'observations individuelles d'une quantité.

la classe est l'un des intervalles dans lesquels est divisée toute la plage de valeurs d'une variable aléatoire.

points extrêmes de la classe - valeurs qui limitent la classe, par exemple 2,5 et 3,0, limites inférieures et supérieures de la classe 2,5 - 3,0.

Fréquence (absolue) de classe - le nombre d'observations dans une classe.

fréquence relative de classe - la fréquence absolue d'une classe, exprimée en fraction du nombre total d'observations.

fréquence cumulée (accumulée) d'une classe - le nombre d'observations égal à la somme des fréquences de toutes les classes précédentes et de cette classe.

Diagramme de Stovptsev - une représentation graphique des fréquences de données pour les classes nominales utilisant des colonnes dont les hauteurs sont directement proportionnelles aux fréquences de classe.

diagramme circulaire - une représentation graphique des fréquences de données pour les classes nominales utilisant des secteurs d'un cercle dont les aires sont directement proportionnelles aux fréquences de classe.

histogramme - une représentation graphique de la distribution de fréquence des données quantitatives avec des zones de rectangles directement proportionnelles aux fréquences de classe.

polygone de fréquence - un graphique de la distribution de fréquence des données quantitatives ; le point correspondant à la fréquence de classe est situé au dessus du milieu de l'intervalle, chacun deux points adjacents sont reliés par un segment de droite.

ogive (courbe cumulative) - un graphique de la distribution des fréquences relatives cumulées.

Toutes les données médicales ont une variabilité inhérente, donc l'analyse des résultats de mesure est basée sur l'étude des informations sur les valeurs prises par la variable aléatoire étudiée.

L'ensemble de toutes les valeurs possibles d'une variable aléatoire est appelé général.

La partie de la population générale enregistrée à la suite des tests est appelée échantillon.

Le nombre d’observations incluses dans l’échantillon est appelé volume de l’échantillon (généralement noté n).

La tâche de la méthode d'échantillonnage est d'utiliser le votant résultant pour faire une estimation correcte de la variable aléatoire étudiée. Par conséquent, la principale exigence d'un échantillon est la réflexion maximale de toutes les caractéristiques de la population générale. Un échantillon qui satisfait à cette exigence est appelé représentatif. La représentativité de l'échantillon détermine la qualité de l'évaluation, c'est-à-dire le degré de correspondance. de l’évaluation au paramètre qu’elle caractérise.

Lors de l'estimation des paramètres d'une population basée sur un électeur (estimation paramétrique), les concepts suivants sont utilisés :

estimation ponctuelle - une estimation d'un paramètre de population sous la forme d'une valeur unique qu'il peut prendre avec la probabilité la plus élevée.

estimation d'intervalle - estimation d'un paramètre de population sous la forme d'un intervalle de valeurs qui a une probabilité donnée de couvrir sa vraie valeur.

Lors de l'utilisation de l'évaluation par intervalles, le concept est utilisé :

intervalle fiable - un intervalle de valeurs qui a une probabilité donnée de couvrir la vraie valeur du paramètre de population lors de l'estimation de l'intervalle.

fiabilité (probabilité fiable) - la probabilité avec laquelle l'intervalle fiable couvre la vraie valeur du paramètre de population.

limites fiables - limites inférieures et supérieures de l'intervalle fiable.

Les conclusions obtenues par les méthodes de statistiques mathématiques sont toujours basées sur un nombre limité et sélectif d'observations, il est donc naturel que pour le deuxième échantillon, les résultats puissent être différents. Cette circonstance détermine le caractère international des conclusions de la statistique mathématique et, par conséquent, large utilisation théorie des probabilités dans la pratique de la recherche statistique.

Un chemin de recherche statistique typique est :

Après avoir estimé les quantités ou les relations entre elles sur la base de données d'observation, ils font l'hypothèse que le phénomène étudié peut être décrit par l'un ou l'autre modèle stochastique.

en utilisant des méthodes statistiques, cette hypothèse peut être confirmée ou rejetée ; une fois confirmé, l'objectif a été atteint - un modèle a été trouvé qui décrit les modèles étudiés ; sinon, le travail se poursuit, en proposant et en testant une nouvelle hypothèse.

Définition d'échantillons d'estimations statistiques :

le mode est la valeur qui apparaît le plus souvent chez le votant,

médiane - valeur centrale (moyenne) de la série de variations

plage R - la différence entre les valeurs les plus grandes et les plus petites d'une série d'observations

percentiles - une valeur dans une série de variations qui divise la distribution en 100 parties égales (ainsi, la médiane sera le cinquantième centile)

premier quartile - 25e centile

troisième quartile - 75e centile

intervalle interquartile - la différence entre le premier et le troisième quartile (couvre les 50 % centraux des observations)

écart quartile - la moitié de l'intervalle interquartile

moyenne de l'échantillon - moyenne arithmétique de toutes les valeurs de l'échantillon (exemple d'estimation de l'espérance mathématique)

écart absolu moyen - la somme des écarts par rapport au début correspondant (sans tenir compte du signe), divisée par le volume de l'échantillon

l'écart absolu moyen par rapport à la moyenne de l'échantillon est calculé à l'aide de la formule

la variance de l'échantillon (X) - (estimation de la variance de l'échantillon) est donnée par

covariance de l'échantillon -- (estimation de l'échantillon de la covariance K ( X,Y )) est égale

le coefficient de régression de Y sur X (échantillon d'estimation du coefficient de régression de Y sur X) est égal à

l'équation de régression linéaire empirique de Y sur X a la forme

le coefficient de régression de l'échantillon de X sur Y (estimation de l'échantillon du coefficient de régression de X sur Y) est égal à

l'équation de régression linéaire empirique de X sur Y a la forme

écart type de l'échantillon s(X) - (estimation de l'écart type de l'échantillon) est égal à la racine carrée de la variance de l'échantillon

coefficient de corrélation de l'échantillon - (échantillon d'estimation du coefficient de corrélation) est égal à

échantillon de coefficient de variation - (échantillon d'estimation du coefficient de variation CV) est égal à

.

8. Tâche de préparation indépendante des étudiants. 8.1 Tâche pour auto-apprentissage matériel du sujet.8.1.1 Calcul pratique des estimations par sondage

Calcul pratique des estimations ponctuelles d'échantillonnageExemple 1.

La durée de la maladie (en jours) dans 20 cas de pneumonie était de :

10, 11, 6, 16, 7, 13, 15, 8, 9, 10, 11, 13, 7, 8, 13, 15, 16, 13, 14, 15

Déterminez le mode, la médiane, l'intervalle, l'intervalle interquartile, la moyenne de l'échantillon, l'écart absolu moyen par rapport à la moyenne de l'échantillon, la dispersion de l'échantillon, le coefficient de variation de l'échantillon.

Rozv"zok.

La série de variations pour l'échantillonnage a la forme

6, 7, 7, 8, 8, 9, 10, 10, 11, 11, 13, 13, 13, 13, 14, 15, 15, 15, 16, 16

Mode

Le nombre le plus courant chez l'électeur est 13. Par conséquent, la valeur du mode chez l'électeur sera ce nombre.

Médian

Lorsqu'une série de variations contient une paire d'observations, la médiane est égale à la moyenne des deux termes centraux de la série, en l'occurrence 11 et 13, la médiane est donc 12.

Portée

La valeur minimale chez un électeur est de 6 et la valeur maximale est de 16, donc R = 10.

Écart interquartile, écart quartile

Dans une série de variations, un quart de toutes les données ont une valeur inférieure à, ou au niveau 8, donc le premier quartile est 8, et 75 % de toutes les données ont une valeur inférieure, ou au niveau 12, donc le troisième quartile est 14. Ainsi , l'intervalle interquartile est de 6 et l'écart quartile est de 3.

Moyenne de l'échantillon

La moyenne arithmétique de toutes les valeurs de l'échantillon est égale à

.

Écart absolu moyen par rapport à la moyenne de l'échantillon

.

Écart de l'échantillon

Exemple d'écart type

.

Coefficient de variation de Birk

.

Dans l'exemple suivant, nous considérerons le moyen le plus simple d'étudier la dépendance stochastique entre deux variables aléatoires.

Exemple 2.

Lors de l'examen d'un groupe de patients, des données ont été obtenues sur la taille H (cm) et le volume sanguin circulant V (l) :

Trouvez des équations de régression linéaire empiriques.

Rozv"zok.

La première chose que vous devez calculer est :

moyenne de l'échantillon

moyenne de l'échantillon

.

La deuxième chose que vous devez calculer est :

variance de l'échantillon (H)

variance de l'échantillon (V)

covariance de l'échantillon

Troisièmement, le calcul des coefficients de régression de l'échantillon :

coefficient de régression de l'échantillon V sur H

coefficient de régression de l'échantillon H sur V

.

Quatrièmement, notez les équations requises :

l'équation de régression linéaire empirique de V sur H a la forme

l'équation de régression linéaire empirique de H sur V a la forme

.

Exemple 3.

A l'aide des conditions et des résultats de l'exemple 2, calculer le coefficient de corrélation et vérifier la fiabilité de l'existence d'une corrélation entre la taille humaine et le volume sanguin circulant avec une probabilité fiable de 95 %.

Rozv"zok.

Le coefficient de corrélation est lié aux coefficients de régression et à une formule pratiquement utile

.

Pour un exemple d'évaluation du coefficient de corrélation, cette formule a la forme

.

En utilisant les valeurs des coefficients de régression de l'échantillon et dans l'exemple 2, on obtient

.

La vérification de la fiabilité de la corrélation entre variables aléatoires (en supposant une distribution normale pour chacune d'elles) s'effectue comme suit :

- calculer la valeur de T

- trouver le coefficient dans le tableau de répartition des étudiants

- l'existence d'une corrélation entre variables aléatoires est confirmée lors de l'exécution de l'inégalité

.

Puisque 3,5 > 2,26, alors avec une probabilité fiable de 95 % d’existence d’une corrélation entre la taille du patient et le volume de sang circulant, elle peut être considérée comme établie.

Estimations d'intervalle pour l'espérance mathématique et la variance

Si la variable aléatoire a une distribution normale, les estimations d'intervalle pour l'espérance mathématique et la variance sont calculées dans l'ordre suivant :

1. trouver la moyenne de l'échantillon ;

2. calculer la variance de l'échantillon et l'écart type de l'échantillon s ;

3. dans le tableau de distribution de Student, en utilisant la probabilité fiable et le volume d'échantillon n, trouvez le coefficient de Student ;

4. L'intervalle fiable pour l'espérance mathématique s'écrit sous la forme

5.dans le tableau de répartition "> et le volume de prélèvement, retrouver les coefficients ;

6. L'intervalle de confiance pour la dispersion s'écrit sous la forme

La valeur de l'intervalle de confiance, la probabilité fiable et le volume d'échantillonnage dépendent les uns des autres. En fait, l'attitude

diminue avec l'augmentation de n, donc, avec une valeur constante de l'intervalle de fiabilité, avec l'augmentation de n, u augmente. Avec une probabilité fiable constante, à mesure que le volume de viborkip augmente, la valeur de l'intervalle fiable diminue. Lors de la planification d'une recherche médicale, cette connexion est utilisée pour déterminer le volume d'échantillonnage minimum qui fournira les valeurs requises de l'intervalle fiable et de la probabilité fiable en fonction des conditions du problème à résoudre.

Exemple 5.

À l’aide des conditions et des résultats de l’exemple 1, trouvez les estimations d’intervalle de l’espérance mathématique et de la variance pour une probabilité fiable de 95 %.

Rozv"zok.

Dans l'exemple 1, les estimations ponctuelles de l'espérance mathématique (moyenne de l'échantillon = 12), de la variance (variance de l'échantillon = 10,7) et de l'écart type (écart type de l'échantillon) sont déterminées. Le volume de l'échantillon est n = 20.

A partir du tableau de distribution de Student, nous trouvons la valeur du coefficient

Ensuite, nous calculons la demi-largeur de l'intervalle de confiance

et notez l'estimation d'intervalle de l'espérance mathématique

10,5 < < 13,5 при = 95%

A partir du tableau de distribution de Pearson "chi carré" on retrouve les coefficients

calculer les limites fiables inférieures et supérieures

et écrivez l'estimation d'intervalle pour la variance sous la forme

6.2 23 à = 95% .

8.1.2. Problèmes à résoudre de manière autonome

Pour une solution indépendante, les problèmes 5.4 C 1 à 8 sont proposés (P.G. Zhumatiy. « Traitement mathématique des données médicales et biologiques. Problèmes et exemples. » Odessa, 2009, pp. 24-25)

8.1.3. Questions de contrôle- Fréquence des cours (absolue et relative).

- Population et échantillon, taille de l'échantillon.

- Estimation de points et d’intervalles.

- Intervalle et fiabilité fiables.

- Mode, médiane et moyenne de l'échantillon.

- Écart, intervalle interquartile, écart trimestriel.

- Écart absolu moyen.

- Covariance et variance de l'échantillon.

- Échantillon d’écart type et coefficient de variation.

- Exemples de coefficients de régression.

- Équations de régression empiriques.

- Calcul du coefficient de corrélation et fiabilité de la corrélation.

- Construction d'estimations d'intervalle de variables aléatoires normalement distribuées.

- Zhumatiy P.G. « Traitement mathématique des données médicales et biologiques. Tâches et exemples. Odessa, 2009.

- Zhumatiy P.G. Conférence « Statistiques mathématiques ». Odessa, 2009.

- Zhumatiy P.G. « Fondamentaux des statistiques mathématiques. » Odessa, 2009.

- Zhumatiy P.G., Senitska Y.R. Éléments de théorie des probabilités. Lignes directrices pour les étudiants des instituts de médecine. Odessa, 1981.

- Chaly O.V., Agapov B.T., Tsekhmister Y.V. Physique médicale et biologique. Kyiv, 2004.

- Remizov O.M. Physique médicale et biologique. M., " lycée”, 1999.

- Remizov O.M., Isakova N.Kh., Maksina O.G.. Recueil de problèmes de physique médicale et biologique. M., ., « Lycée », 1987.

Envoyer votre bon travail dans la base de connaissances est simple. Utilisez le formulaire ci-dessous

Les étudiants, étudiants diplômés, jeunes scientifiques qui utilisent la base de connaissances dans leurs études et leur travail vous seront très reconnaissants.

Posté sur http://www.allbest.ru/

Introduction

Les statistiques mathématiques sont la science de méthodes mathématiques systématisation et utilisation de données statistiques à des fins scientifiques et conclusions pratiques. Dans plusieurs de ses sections, les statistiques mathématiques sont basées sur la théorie des probabilités, qui permet d'évaluer la fiabilité et l'exactitude des conclusions tirées sur la base d'un matériel statistique limité (par exemple, estimer la taille d'échantillon requise pour obtenir des résultats avec la précision requise dans une enquête par sondage).

La théorie des probabilités considère des variables aléatoires avec une distribution donnée ou des expériences aléatoires dont les propriétés sont entièrement connues. Le sujet de la théorie des probabilités concerne les propriétés et les relations de ces quantités (distributions).

Mais souvent, une expérience est une boîte noire qui ne produit que certains résultats, à partir desquels il est nécessaire de tirer une conclusion sur les propriétés de l'expérience elle-même. L'observateur dispose d'un ensemble de résultats numériques (ou ils peuvent être rendus numériques) obtenus en répétant la même expérience aléatoire dans les mêmes conditions.

Dans ce cas, par exemple, les questions suivantes se posent : si nous observons une variable aléatoire, comment pouvons-nous tirer la conclusion la plus précise sur sa distribution sur la base d'un ensemble de ses valeurs dans plusieurs expériences ? histogramme de dispersion des statistiques mathématiques

Un exemple d’une telle série d’expériences pourrait être une enquête sociologique, un ensemble d’indicateurs économiques ou, enfin, une séquence de pile et face lorsqu’une pièce de monnaie est lancée mille fois. Tous les facteurs ci-dessus déterminent la pertinence et l'importance du sujet de travail sur scène moderne visant à une étude approfondie et complète des concepts de base des statistiques mathématiques.

1. Sujet et méthode des statistiques mathématiques

Selon la nature mathématique des résultats d'observation spécifiques, les statistiques mathématiques sont divisées en statistiques de nombres, analyse statistique multidimensionnelle, analyse de fonctions (processus) et de séries chronologiques, statistiques d'objets de nature non numérique. Une partie importante des statistiques mathématiques repose sur des modèles probabilistes. Les tâches générales de description des données d'évaluation et de test des hypothèses sont identifiées. Ils envisagent également des tâches plus spécifiques liées à la réalisation d'enquêtes par sondage, à la restauration des dépendances, à la construction et à l'utilisation de classifications (typologies), etc.

Pour décrire les données, des tableaux, des diagrammes et d'autres représentations visuelles, telles que des champs de corrélation, sont construits. Les modèles probabilistes ne sont généralement pas utilisés. Certaines méthodes de description des données s’appuient sur une théorie avancée et sur les capacités des ordinateurs modernes. Il s'agit notamment de l'analyse groupée visant à identifier des groupes d'objets similaires les uns aux autres et de la mise à l'échelle multidimensionnelle, qui permet de représenter visuellement les objets sur un plan avec le moins de distorsion des distances entre eux.

Les méthodes d'évaluation et de test des hypothèses sont basées sur des modèles probabilistes de génération de données. Ces modèles sont divisés en paramétriques et non paramétriques. Dans les modèles paramétriques, on suppose que les objets étudiés sont décrits par des fonctions de distribution dépendant d'un petit nombre (1-4) de paramètres numériques. Dans les modèles non paramétriques, les fonctions de distribution sont supposées être arbitrairement continues. En statistique mathématique, les paramètres et caractéristiques de la distribution (espérance mathématique, médiane, dispersion, quantiles, etc.) des fonctions de densité et de distribution de la dépendance entre variables (basées sur des coefficients de corrélation linéaires et non paramétriques, ainsi que des estimations paramétriques ou non paramétriques de fonctions exprimant des dépendances), etc.. Estimations de points et d'intervalles (donnant des limites pour les valeurs vraies).

En statistique mathématique, il y a théorie générale tests d’hypothèses et un grand nombre de méthodes dédiées au test d’hypothèses spécifiques. Ils considèrent des hypothèses sur les valeurs des paramètres et des caractéristiques, testent l'homogénéité (c'est-à-dire la coïncidence de caractéristiques ou de fonctions de distribution dans deux échantillons), l'accord de la fonction de distribution empirique avec une fonction de distribution donnée ou avec une famille paramétrique de telles fonctions, la symétrie de la distribution, etc.

La section des statistiques mathématiques associée à la réalisation d'enquêtes par sondage avec les propriétés de divers schémas d'échantillonnage et à la construction de méthodes adéquates pour évaluer et tester les hypothèses est d'une grande importance.

Les problèmes de rétablissement de la dépendance sont activement étudiés depuis plus de 200 ans depuis le développement de la méthode des moindres carrés par K. Gauss en 1794. Actuellement, les méthodes les plus pertinentes pour rechercher un sous-ensemble informatif de variables et les méthodes non paramétriques.

Le développement de méthodes d'approximation des données et de réduction de la dimensionnalité des descriptions a commencé il y a plus de 100 ans lorsque K. Pearson a créé la méthode des composantes principales. L'analyse factorielle et de nombreuses généralisations non linéaires ont ensuite été développées.

Diverses méthodes de construction (analyse cluster) d'analyse et d'utilisation (analyse discriminante) de classifications (typologies) sont également appelées méthodes de reconnaissance de formes (avec et sans enseignant), de classification automatique, etc.

Les méthodes mathématiques en statistique reposent soit sur l'utilisation de sommes (basées sur la Centrale Théorème limite théorie des probabilités) ou des indices de différence (distances métriques) comme dans les statistiques d'objets de nature non numérique. Habituellement, seuls les résultats asymptotiques sont strictement justifiés. De nos jours, les ordinateurs jouent un rôle important dans les statistiques mathématiques. Ils sont utilisés aussi bien pour les calculs que pour la modélisation de simulation (notamment dans les méthodes de multiplication d'échantillons et dans l'étude de la pertinence des résultats asymptotiques).

1.1 Concepts de base des statistiques mathématiques

Un rôle extrêmement important dans l'analyse de nombreux phénomènes psychologiques et pédagogiques est joué par les valeurs moyennes, qui représentent une caractéristique généralisée d'une population qualitativement homogène selon un certain critère quantitatif. Il est impossible, par exemple, de calculer la spécialité moyenne ou la nationalité moyenne des étudiants universitaires, car il s'agit de phénomènes qualitativement hétérogènes. Mais il est possible et nécessaire de déterminer les caractéristiques numériques moyennes de leurs performances académiques ( GPA), l'efficacité des systèmes et techniques méthodologiques, etc.

Dans la recherche psychologique et pédagogique, différents types de moyennes sont généralement utilisés : moyenne arithmétique, moyenne géométrique, médiane, mode et autres. Les plus courants sont la moyenne arithmétique, la médiane et le mode.

La moyenne arithmétique est utilisée dans les cas où il existe une relation directement proportionnelle entre la propriété déterminante et cet attribut (par exemple, lorsque les indicateurs de performance d'un groupe de formation s'améliorent, les indicateurs de performance de chacun de ses membres s'améliorent).

La moyenne arithmétique est le quotient de la somme des quantités divisée par leur nombre et est calculée à l'aide de la formule :

Posté sur http://www.allbest.ru/

où X est la moyenne arithmétique ; X1, X2, X3 ... Xn - résultats d'observations individuelles (techniques, actions),

n - nombre d'observations (techniques, actions),

La somme des résultats de toutes les observations (techniques, actions).

La médiane (Me) est une mesure de position moyenne qui caractérise la valeur d'une caractéristique sur une échelle ordonnée (basée sur une augmentation ou une diminution), qui correspond au milieu de la population étudiée. La médiane peut être déterminée pour les caractéristiques ordinales et quantitatives. L'emplacement de cette valeur est déterminé par la formule :

Localisation médiane = (n + 1) / 2

Par exemple. Selon les résultats de l’étude, il a été constaté que :

5 des personnes participant à l'expérience ont obtenu d'excellentes notes ;

« Bons » étudiants - 18 personnes ;

« satisfaisant » - 22 personnes ;

"Insatisfaisant" - 6 personnes.

Puisqu’un total de N = 54 personnes ont participé à l’expérience, le milieu de l’échantillon est égal à une personne. On en conclut que plus de la moitié des étudiants étudient en dessous de la note « bonne », c'est-à-dire que la médiane est plus « satisfaisante », mais moins que « bonne ».

Le mode (Mo) est la valeur typique la plus courante d'une caractéristique parmi d'autres valeurs. Elle correspond à la classe avec la fréquence maximale. Cette classe est appelée valeur modale.

Par exemple.

Si la question de l'enquête : « indiquer le degré de maîtrise d'une langue étrangère », les réponses ont été distribuées :

1 - courant - 25

2 - Je parle suffisamment pour communiquer - 54

3 - Je parle, mais j'ai du mal à communiquer - 253

4 - Je comprends difficilement - 173

5 - Je ne sais pas - 28

Évidemment, la signification la plus typique ici est « Je le possède, mais j'ai des difficultés à communiquer », qui sera modale. Le mode est donc - 253.

Lors de l'utilisation de méthodes mathématiques dans la recherche psychologique et pédagogique, une grande importance est accordée au calcul de la dispersion et des écarts types.

La dispersion est égale au carré moyen des écarts de la valeur des options par rapport à la valeur moyenne. Il s'agit de l'une des caractéristiques des résultats individuels de la dispersion des valeurs de la variable étudiée (par exemple, les notes des étudiants) autour de la valeur moyenne. Le calcul de la dispersion s'effectue en déterminant : l'écart par rapport à la valeur moyenne ; le carré de l'écart spécifié ; la somme des écarts carrés et de l’écart quadratique moyen.

La valeur de la variance est utilisée dans divers calculs statistiques, mais n'est pas directement observable. La valeur directement liée au contenu de la variable observée est l'écart type.

L'écart type confirme la typicité et le caractère indicatif de la moyenne arithmétique et reflète la mesure de la fluctuation des valeurs numériques des caractéristiques à partir desquelles est dérivée la valeur moyenne. Elle est égale à la racine carrée de la variance et est déterminée par la formule :

(2)Publié le http://www.allbest.ru/

où : - carré moyen. Si le nombre d'observations (actions) est faible - inférieur à 100 - dans la valeur de la formule, vous ne devez pas mettre « N », mais « N - 1 ».

La moyenne arithmétique et la moyenne quadratique sont les principales caractéristiques des résultats obtenus au cours de l'étude. Ils permettent de résumer les données, de les comparer et d'établir les avantages d'un système (programme) psychologique et pédagogique par rapport à un autre.

L’écart quadratique moyen (type) est largement utilisé comme mesure de dispersion pour diverses caractéristiques.